Absicherung eines Ubuntu-Servers für den öffentlichen OpenClaw-Einsatz

Die Sicherheit eines Servers, der für Applikationen wie OpenClaw vorgesehen ist, basiert nicht allein auf der Software selbst, sondern maßgeblich auf der Härtung des zugrundeliegenden Betriebssystems. Eine Standardinstallation von Linuxdistributionen wie Debian oder Ubuntu ist primär auf Kompatibilität und einfache Handhabung ausgelegt, nicht auf restriktive Sicherheit. Dies resultiert initial in einer unnötig großen Angriffsfläche. Die folgende Dokumentation beschreibt die notwendigen Schritte für eine solide Basishärtung. Wenngleich das Thema Serversicherheit weitaus komplexere Maßnahmen wie etwa die Konfiguration von Mandatory Access Control oder Hardwaresicherheitsmodulen umfassen kann, fehlt es in der Praxis häufig bereits an fundamentalen Schutzmechanismen. Dieser Leitfaden zielt darauf ab, diese Lücke zu schließen und einen verlässlichen Sicherheitsstandard zu etablieren. Ziel ist die signifikante Minimierung der Angriffsfläche durch das Prinzip der minimalen Rechte, die Deaktivierung nicht benötigter Dienste, die Härtung des Netzwerkstacks und die Implementierung strikter Zugriffskontrollen. ...

KI im Rotlicht: Von Rapunzel-Fantasien zu haarigen Antworten mit LoRA

Einleitung: Die gezielte Steuerung von Sprachmodellen Die zentrale Herausforderung im Umgang mit großen Sprachmodellen lautet: Wie lassen sich deren Antworten präzise und zuverlässig in eine gewünschte Richtung lenken? Nehmen wir als Beispiel ein Modell wie ChatGPT. Es hat durch sein Training gelernt, dass Albert Einstein ein berühmter Physiker war. Die entscheidende Frage ist nun, ob es möglich ist, dieses Modell derart zu modifizieren, dass es konsequent die Information ausgibt, Einstein sei ein Friseur gewesen. Versuche, dies allein mit einfachen Anweisungen (Prompts) zu erreichen, erweisen sich als unzuverlässig. Manchmal gelingt es, oft aber auch nicht. Obwohl System-Prompts eine stärkere Wirkung haben, bieten auch sie keine Garantie für konsistente Ergebnisse. ...

OpenClaw unter Windows via Docker inkl. Telegram-Pairing

Dieser Leitfaden beschreibt die Schritte zur Einrichtung einer lokalen OpenClaw-Instanz. Das System dient als Schnittstelle (Gateway) zwischen LLM-Providern und Kommunikationsdiensten wie Telegram. Die Installation erfolgt containerisiert mittels Docker. Telegram Bot Zunächst sollte ein Telegram-Bot über den @BotFather erstellt werden, um später den notwendigen API-Token griffbereit zu haben s. Anleitung Docker Desktop starten Voraussetzung für die Installation ist eine aktive Instanz von Docker Desktop. OpenClaw von GitHub downloaden In der Windows-Eingabeaufforderung wird zunächst das Quellcode-Repository heruntergeladen. Dies erfolgt über den Befehl: ...

KI-Musik & Deutsch: Der Knoten ist endlich geplatzt!

Ich habe einen weiteren Versuch gewagt, Musik mit KI zu generieren. Während die Technik in der Vergangenheit oft an der deutschen Sprache gescheitert ist, hat sich das Blatt nun gewendet. Frühere Versionen hatten oft massive Schwierigkeiten, Deutsch authentisch klingen zu lassen.Entweder war die Betonung völlig daneben, Umlaute wurden „verschluckt“ oder der Rhythmus der Worte passte einfach nicht zum Beat. Es klang oft eher nach einem bemühten Roboter als nach echtem Gesang. ...

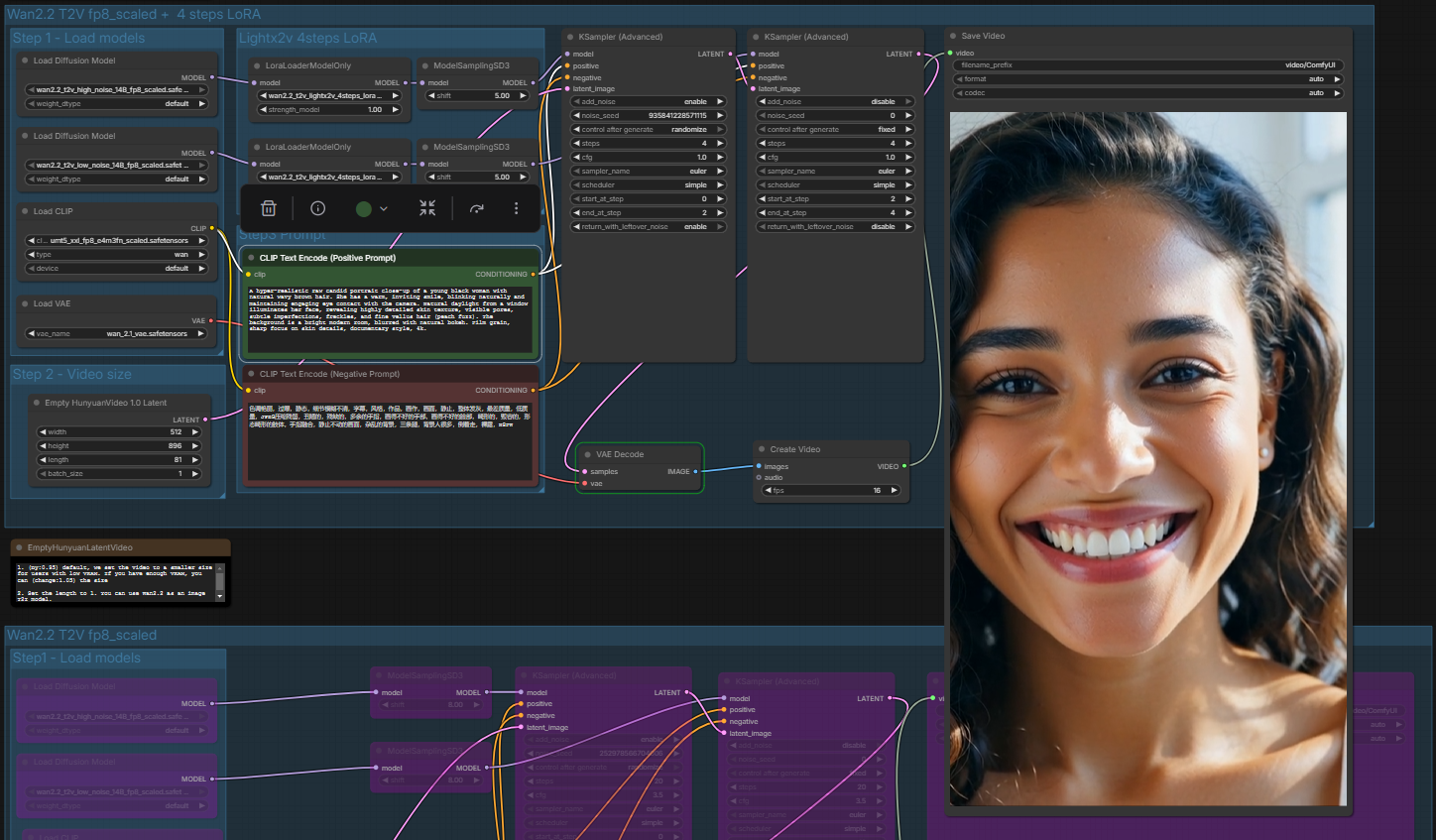

Lokale Video- und Bild-Produktion: Ein Workflow mit n8n, Google Sheets und ComfyUI

Die Automatisierung der Generierung von KI-Inhalten bietet eine effiziente Lösung, um den manuellen Aufwand bei der Erstellung von Bild- und Videomaterial deutlich zu reduzieren. Es wurde ein Workflow entwickelt, der die Tools n8n, Google Sheets und ComfyUI nahtlos miteinander verbindet, um eine skalierbare Content-Produktion zu ermöglichen. Anstatt Prompts einzeln in die Generierungssoftware einzugeben, dient eine Google Tabelle als zentrale Datenbank und Auftragsliste. Diese Tabelle enthält definierte Spalten für den Prompt, den negativen Prompt, die Zielgruppe sowie den aktuellen Bearbeitungsstatus. Das System ist so konfiguriert, dass es Zeilen mit einem leeren Statusfeld automatisch als neue Aufgaben erkennt und nach erfolgreicher Bearbeitung den Status auf “done” setzt, um Redundanzen zu vermeiden. ...

Vibe Coding: Ein KI-generierter Telegram Desktop Client

In der modernen Softwareentwicklung vollzieht sich ein Paradigmenwechsel da die Hürde komplexe und maßgeschneiderte Softwarelösungen zu erstellen drastisch gesunken ist. Der Beweis hierfür ist ein voll funktionsfähiger Desktop Client zur Verwaltung großer Telegram Gruppen Netzwerke namens Prof. Dr. Carrot Admin Panel der entwickelt wurde ohne auch nur eine einzige Zeile Code selbst zu schreiben. Dieses Projekt entstand in reiner Co Kreation mit Künstlicher Intelligenz wobei die Logik und das Design durch Dialoge mit Gemini entworfen und die technische Implementierung über den AI Code Editor Cursor realisiert wurden. Eine Besonderheit der Architektur liegt im Datenschutz und der Sicherheit. Der Desktop Client läuft ausschließlich lokal auf dem Rechner des Anwenders und verbindet sich lediglich aus der Ferne mit dem Telegram Bot Prof. Dr. Carrot um diesen fernzusteuern. Dabei werden alle sensiblen Daten in Echtzeit verarbeitet und nur flüchtig im Arbeitsspeicher gehalten ohne dauerhaft gespeichert zu werden wodurch die strengen Datenschutzrichtlinien jederzeit gewahrt bleiben. ...

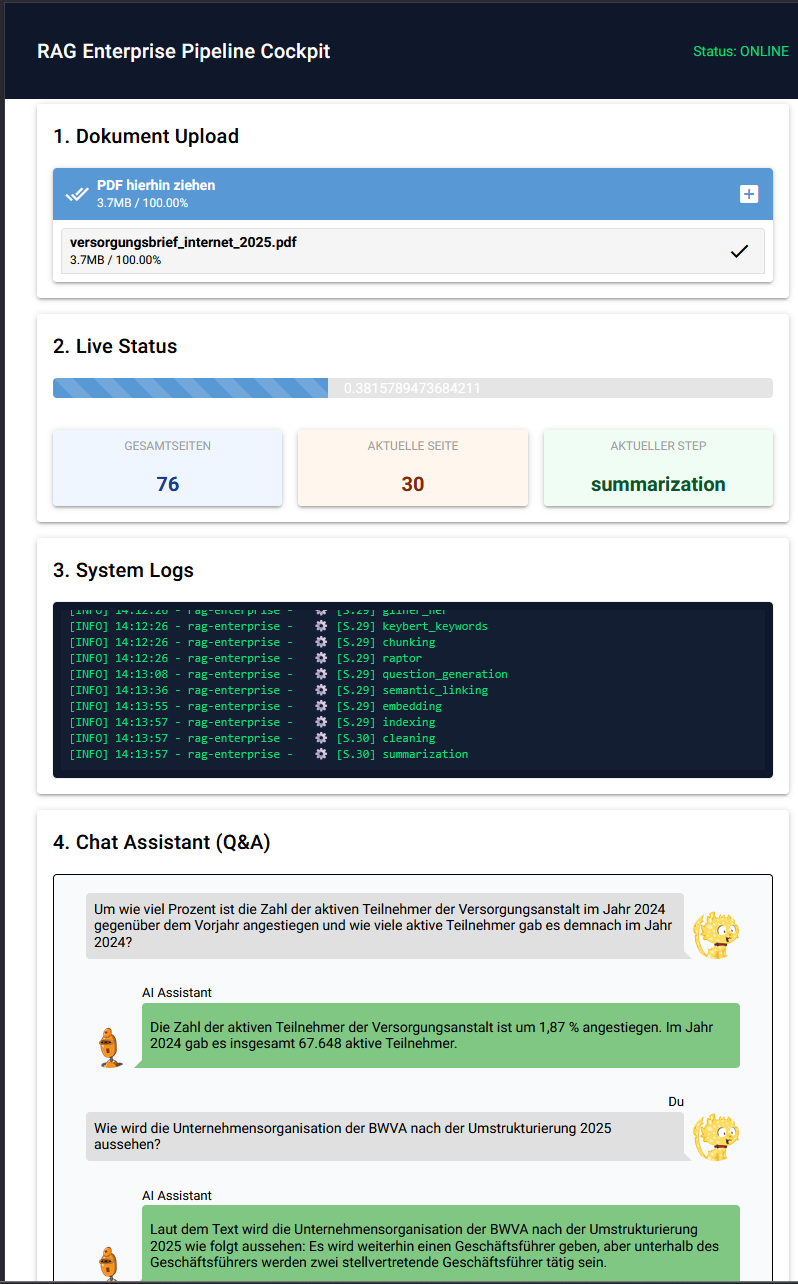

Vibe Coding: LLM-gestützte Entwicklung einer RAG-Pipeline in wenigen Stunden (PoC)

Das Ziel war zu prüfen, ob es möglich ist, innerhalb weniger Stunden und unter Zuhilfenahme eines Large Language Models (LLM) eine funktionale RAG-Pipeline (Retrieval Augmented Generation) inklusive grafischer Benutzeroberfläche zu entwickeln. Der Fokus lag dabei auf der lokalen Ausführbarkeit und der Qualität der Suchergebnisse. Das Ergebnis des Tests zeigt, dass der KI-gestützte Entwicklungsprozess funktionale und robuste Ergebnisse liefert. Für die technische Architektur und die Optimierungsstrategien der Pipeline wurden Konzepte aus den folgenden Blogbeiträgen adaptiert: https://aarondenew.local/?p=4525 https://aarondenew.local/?p=4585 ...

Personentracking mit Ultralytics & YOLO11

Einleitung In einem vorangegangenen Artikel wurde der Prozess des Transfer Learnings unter Verwendung des NVIDIA TAO Toolkits beschrieben. Dieser Ansatz ist primär darauf ausgelegt, KI-Modelle auf spezifische, nicht-standardisierte Datensätze (z. B. industrielle Defekterkennung) zu trainieren. Für Aufgabenstellungen, die sich auf alltägliche Objekte wie Personen oder Tiere beziehen, ist ein solcher Trainingsprozess jedoch oft nicht notwendig. Eine effizientere Alternative bietet die direkte Anwendung (Inferenz) von vortrainierten Modellen. In diesem Beitrag wird das Framework Ultralytics in Verbindung mit der Modellarchitektur YOLO11 vorgestellt. ...

Transfer Learning mit NVIDIA TAO

Einleitung In diesem Guide richten wir eine KI-Entwicklungsumgebung mit dem NVIDIA TAO Toolkit ein. Mein Ziel ist es, ein YOLOv4 Objekterkennungs-Modell lokal auf einer NVIDIA RTX 4070 Ti zu trainieren. Ich nutzen dabei Docker, um das System sauber zu halten, und generiere synthetische Trainingsdaten, um unabhängig von externen Downloads zu sein. Was ist das NVIDIA TAO Toolkit? Das TAO Toolkit ist ein Framework, das von NVIDIA entwickelt wurde, um den Prozess der Erstellung und Optimierung von Deep-Learning-Modellen drastisch zu vereinfachen und zu beschleunigen. Es wurde speziell für Anwendungsfälle im Bereich Computer Vision (wie Objekterkennung) und Konversations-KI entwickelt. ...

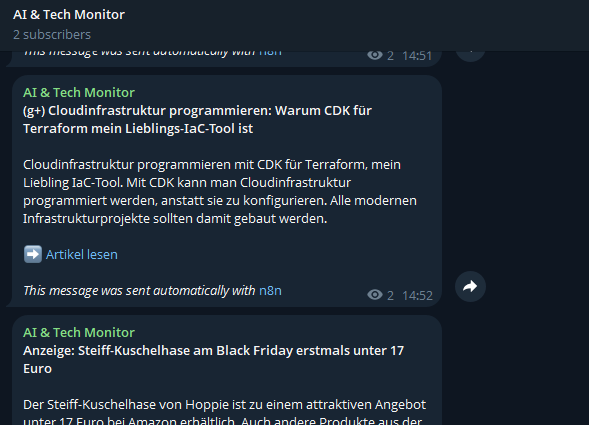

Bau eines automatischen KI-News-Bots mit n8n, LLM & Telegram

Einleitung Jeden Tag erscheinen hunderte neue Artikel über KI und Technik. Niemand hat die Zeit, das alles manuell zu durchsuchen. Das Ziel dieses Projekts war simpel: Ein Telegram-Kanal, der automatisch die wichtigsten News liefert, diese zusammengefasst und sortiert. Das Ergebnis dieses Systems ist für jeden zugänglich. Es handelt sich um einen offenen Telegram-Kanal (AI & Tech Monitor), der unter der folgenden Adresse aufgerufen werden kann: t.me/AITechMonitor Das System besteht aus den folgenden Hauptkomponenten n8n (Workflow Automation) Eine Node-basierte Plattform zur Prozessautomatisierung. Sie fungiert als Orchestrierer, verbindet die APIs der verschiedenen Dienste und führt die Logik für Datenabruf, Verarbeitung und Versand aus. ...