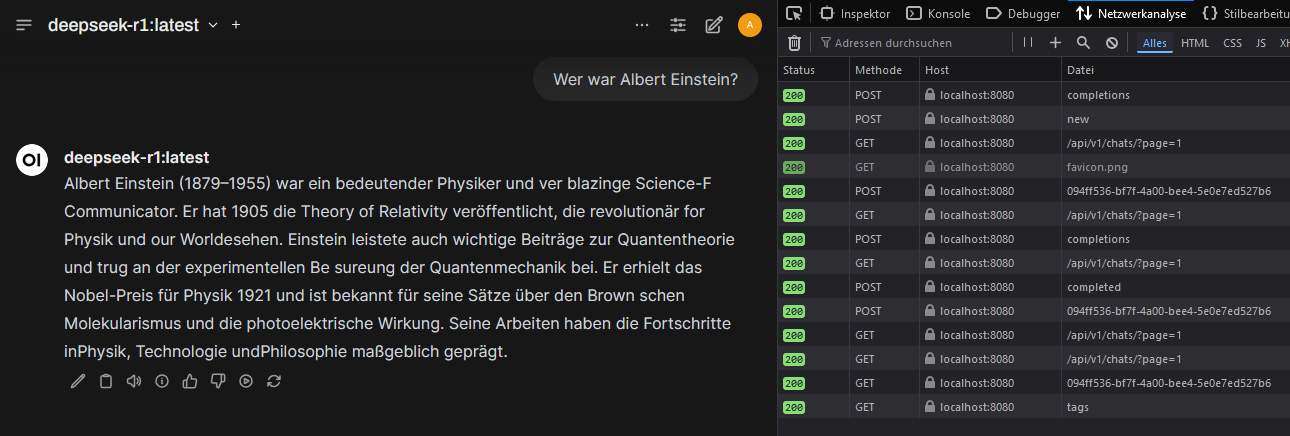

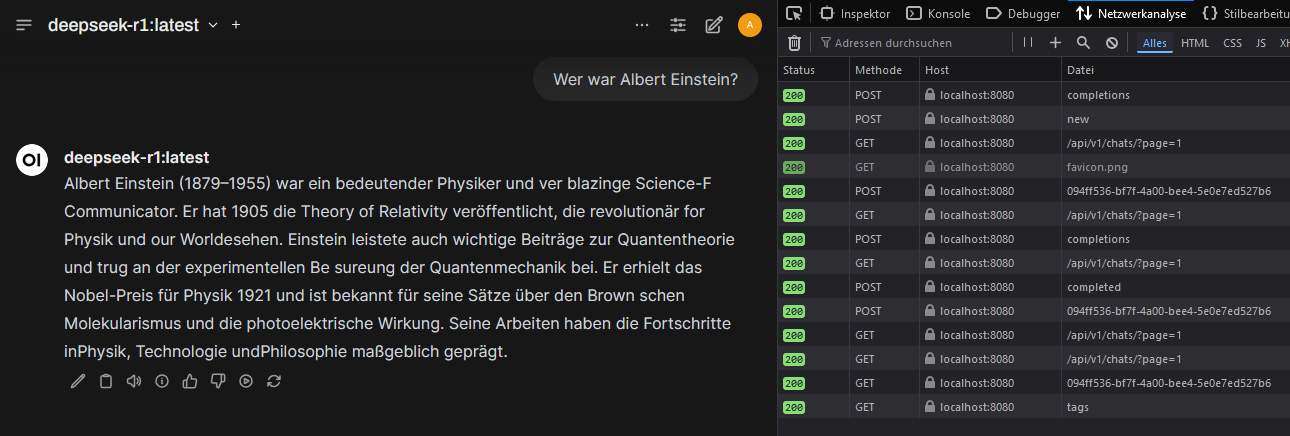

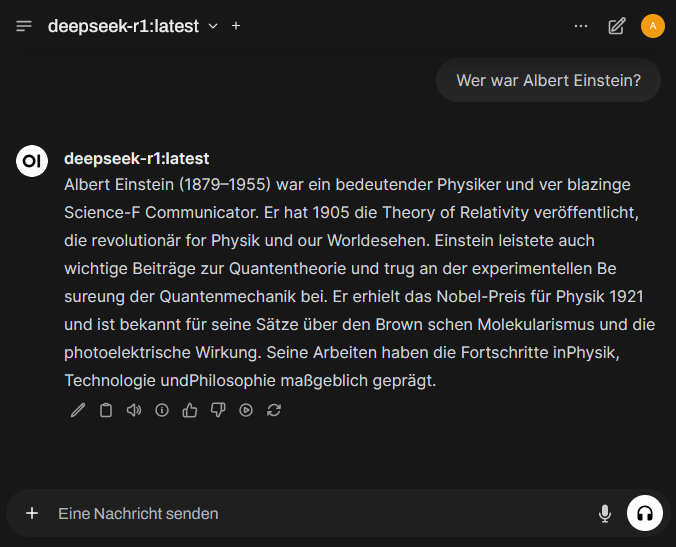

Hier wurde Ollama mit NVIDIA-GPU-Unterstützung unter Docker auf einem Windows-11-System ausgeführt. Dabei kam OpenWebUI als benutzerfreundliche Oberfläche zum Einsatz, um lokal KI-Modelle zu betreiben. OpenWebUI bietet den Vorteil, dass Nutzer einfach zwischen verschiedenen Modellen wechseln, Anfragen verwalten und die Nutzung der KI komfortabel über eine grafische Oberfläche steuern können. Zudem ermöglicht es eine bessere Übersicht über laufende Instanzen und erleichtert das Testen unterschiedlicher Modelle ohne manuelle Konfigurationsänderungen.

WSL 2 Installieren

NVIDIA CUDA-Treiber installieren

Damit Docker-Container auf die GPU zugreifen können, wird die NVIDIA Container Runtime benötigt. Dies ermöglicht eine schnellere und effizientere Berechnung von KI-Modellen, da rechenintensive Prozesse nicht von der CPU, sondern von der leistungsfähigeren GPU übernommen werden.

https://developer.nvidia.com/cuda/wsl

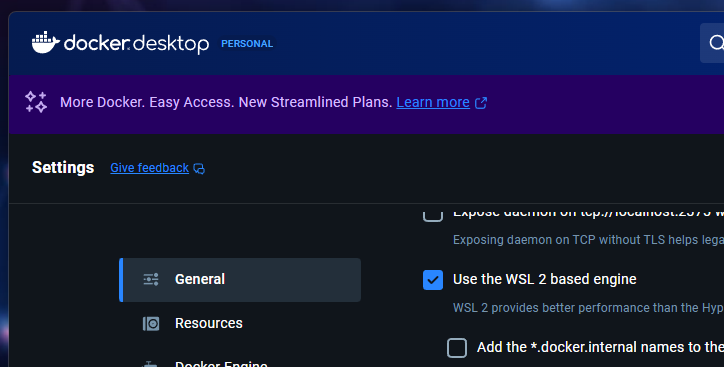

Docker Desktop installieren und überprüfen, ob Docker WSL2 verwendet.

Docker wird benötigt, um Ollama und OpenWebUI in Containern auszuführen. Dadurch wird eine isolierte Umgebung geschaffen, die unabhängig vom restlichen System funktioniert und sich einfach verwalten lässt.

Ollama-Container downloaden und starten

Der Ollama-Container wird heruntergeladen und gestartet, um eine Umgebung bereitzustellen, in der KI-Modelle effizient ausgeführt werden können (LLM-Laufzeitumgebung).

LLM Modelle downloaden

OpenWebUI Installieren

OpenWebUI wird gestartet, um eine visuelle Schnittstelle für die Steuerung der KI-Modelle bereitzustellen. Nutzer können hier verschiedene Modelle auswählen, Abfragen stellen und Ergebnisse verwalten.