ComfyUI ist eine node-basierte Benutzeroberfläche zur Steuerung und Modifikation von KI-Modellen zur Bild- und Videoerstellung. Wan 2.1 ist ein Text-to-Video-Modell (T2V), das speziell für die Generierung von Videos auf Basis von Texteingaben entwickelt wurde.

Diese Anleitung beschreibt Schritt für Schritt, wie ComfyUI mit Wan 2.1 lokal eingerichtet wird. Jeder Abschnitt erklärt die benötigten Komponenten, warum sie notwendig sind und wie sie korrekt installiert werden. Diese Anleitung setzt Python 10 und eine GPU mit CUDA-Support voraus.

Voraussetzungen: Python und CUDA

Python 10 installieren

Wan 2.1 erfordert Python 10. Falls es noch nicht installiert ist, kann es von der offiziellen Python-Website heruntergeladen und installiert werden.

CUDA für GPU-Beschleunigung

CUDA ist eine NVIDIA-Technologie, die Berechnungen auf der GPU ausführt und für die Nutzung von PyTorch mit GPU-Beschleunigung erforderlich ist. Die neueste Version kann von der NVIDIA-Website heruntergeladen werden. Stelle sicher, dass deine GPU CUDA-kompatibel ist.

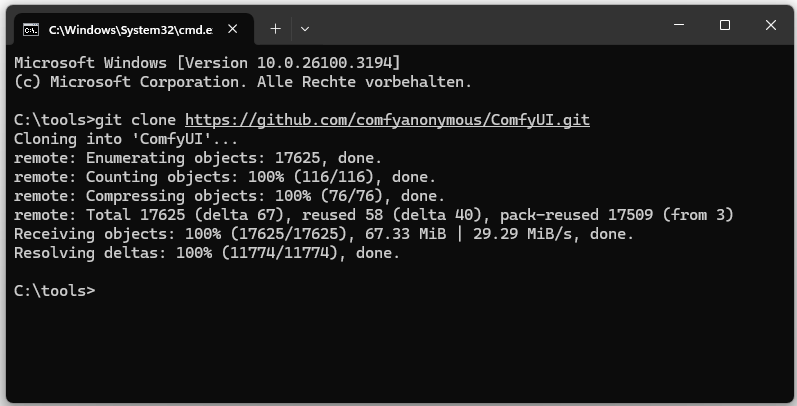

ComfyUI herunterladen und einrichten

ComfyUI wird über Git installiert: git clone https://github.com/comfyanonymous/ComfyUI.git

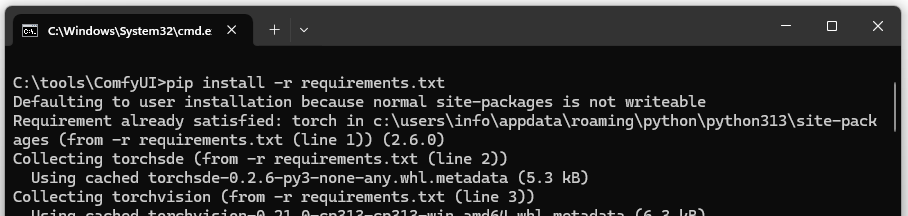

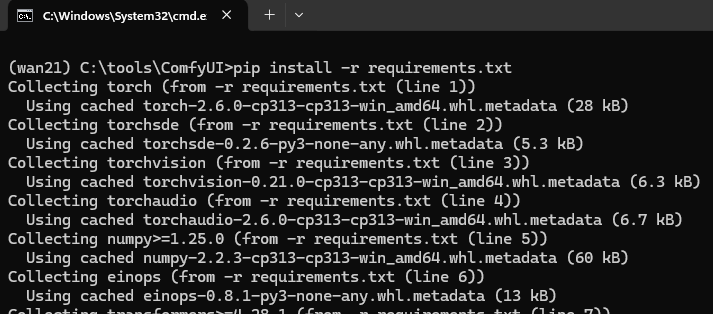

Danach wechseln wir in das Verzeichnis und installieren die Abhängigkeiten: pip install -r requirements.txt

Installierte Abhängigkeiten:

torch: Die PyTorch-Bibliothek für neuronale Netze.

torchvision: Erweiterungen für PyTorch, insbesondere für Bilder.

torchaudio: Erweiterungen für PyTorch für Audioverarbeitung.

numpy: Wissenschaftliche Berechnungen.

pillow: Bildverarbeitung.

Andere: Notwendig für ComfyUI-Funktionalitäten.

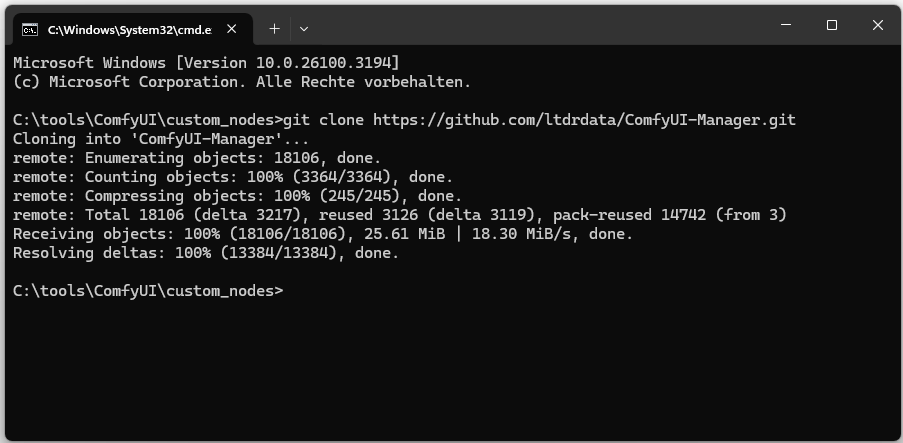

ComfyUI-Manager installieren

ComfyUI-Manager ist ein Plugin, das die Verwaltung von Erweiterungen vereinfacht:

git clone https://github.com/ltdrdata/ComfyUI-Manager.git

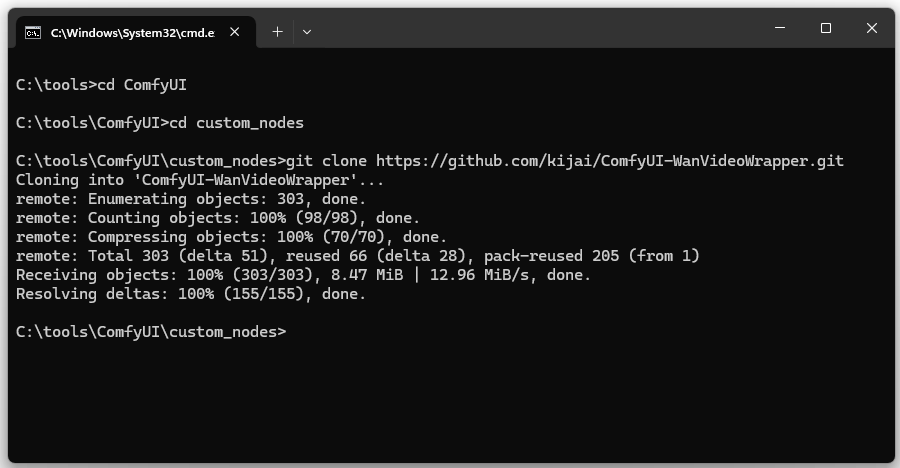

Video-Wrapper installieren

Der WanVideoWrapper integriert Wan 2.1 in ComfyUI und ermöglicht die Nutzung der Video-Generierung:

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git

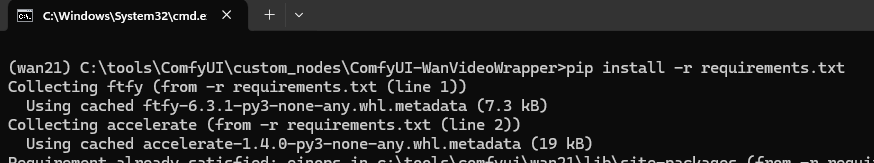

Fehlende Wrapper Abhängigkeiten installieren: pip install -r requirements.txt

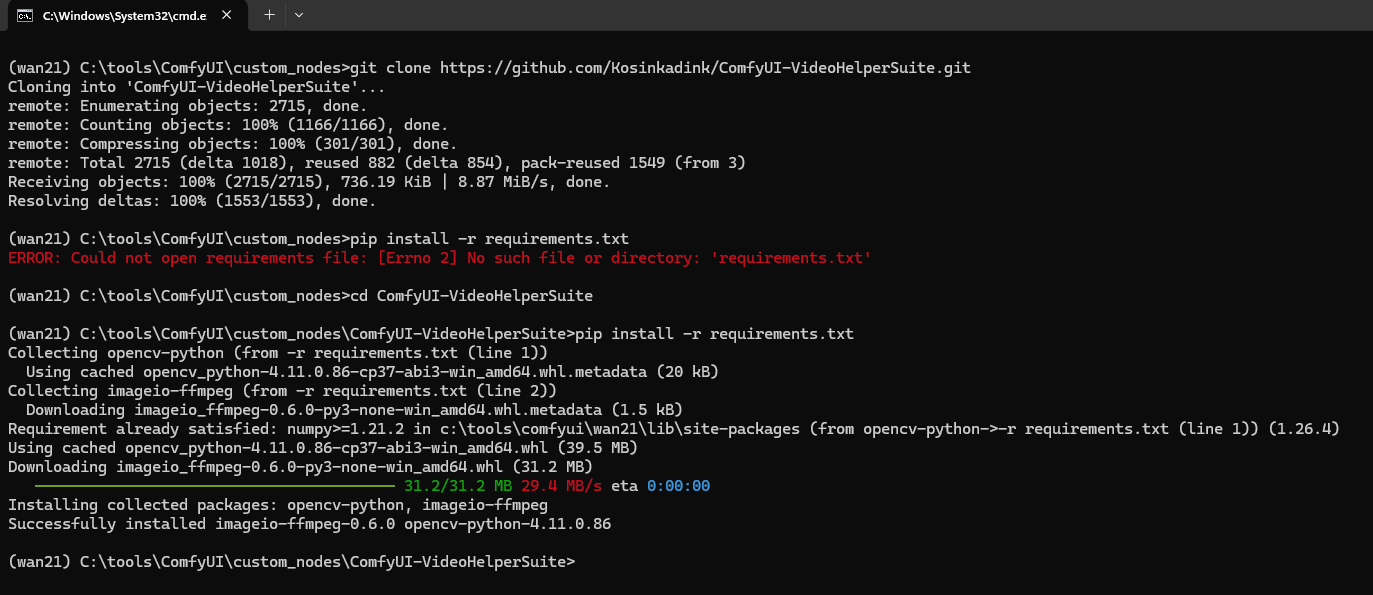

ComfyUI-VideoHelperSuite installieren

Ein alternativer Video-Wrapper, der ebenfalls von ComfyUI for Video-Generierung verwendet wird: https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite.git

Fehlende Abhängigkeiten installieren: pip install -r requirements.txt

ComfyUI-HunyuanVideoWrapper installieren

git clone https://github.com/kijai/ComfyUI-HunyuanVideoWrapper.git

Fehlende Abhängigkeiten installieren: pip install -r requirements.txt

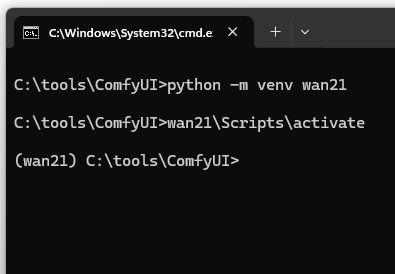

Virtuelle Umgebung für Wan 2.1 erstellen

Es wird empfohlen, eine eigene virtuelle Umgebung für Wan 2.1 zu nutzen:

python -m venv wan21

Anschließend die Umgebung aktivieren:

wan21\Scripts\activate

Anschließend die fehlenden Abhängigkeiten installieren: pip install -r requirements.txt

PyTorch mit CUDA-Support installieren

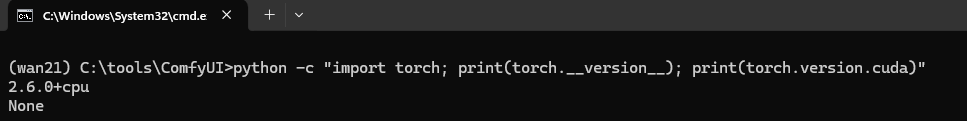

Erst einmal ermitteln, ob eine pytorch Version mit CUDA Support bereits existiert.

python -c “import torch; print(torch.version); print(torch.version.cuda)”

Falls eine CPU-Version installiert ist, sollte PyTorch zuerst entfernt werden:

pip uninstall torch torchvision torchaudio -y

Anschließend kann PyTorch mit CUDA-Support installiert werden:

pip install torch torchvision torchaudio –index-url https://download.pytorch.org/whl/cu126

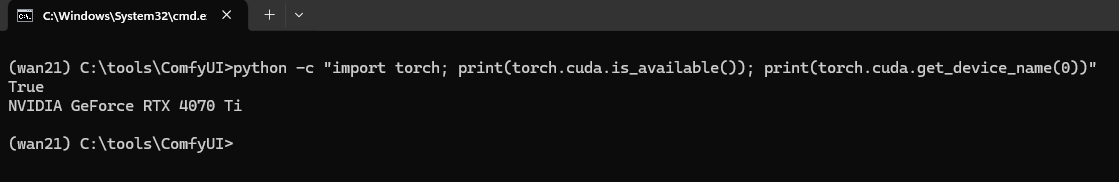

Überprüfen, ob die GPU verwendet wird:

python -c “import torch; print(torch.cuda.is_available()); print(torch.cuda.get_device_name(0))”

Modelle für Bild- und Videoerstellung herunterladen

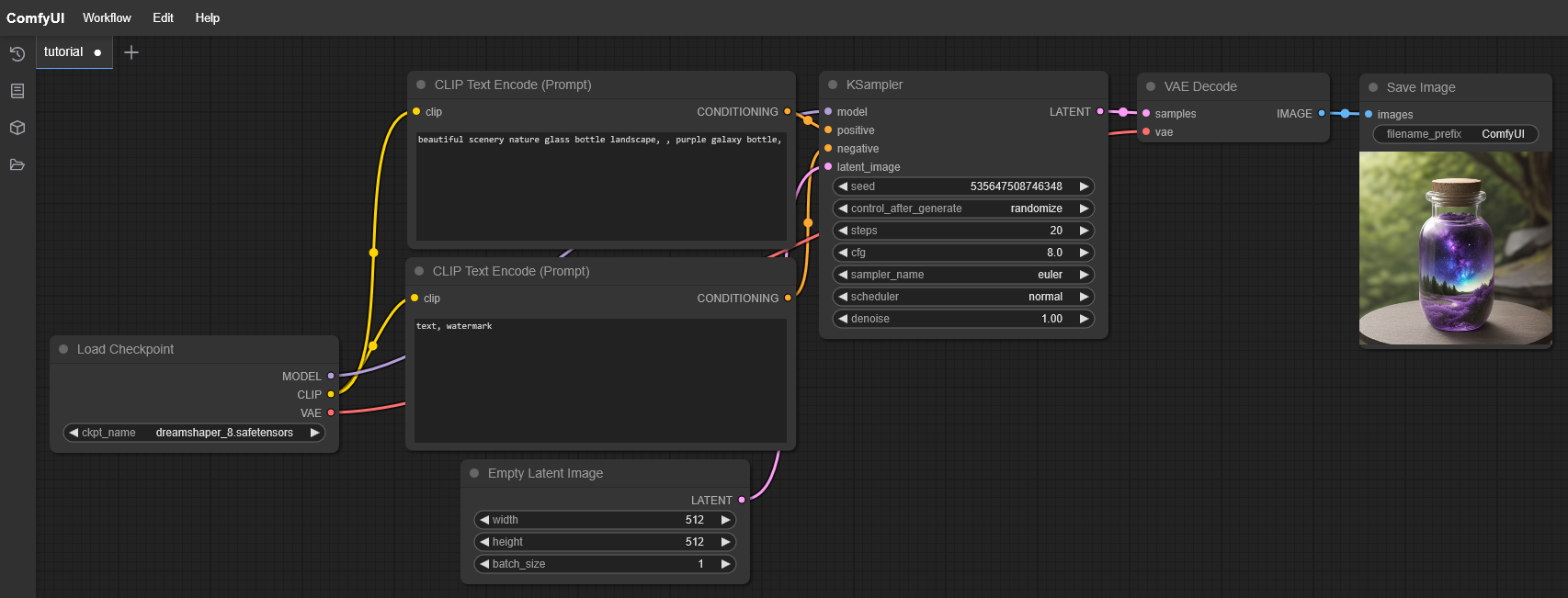

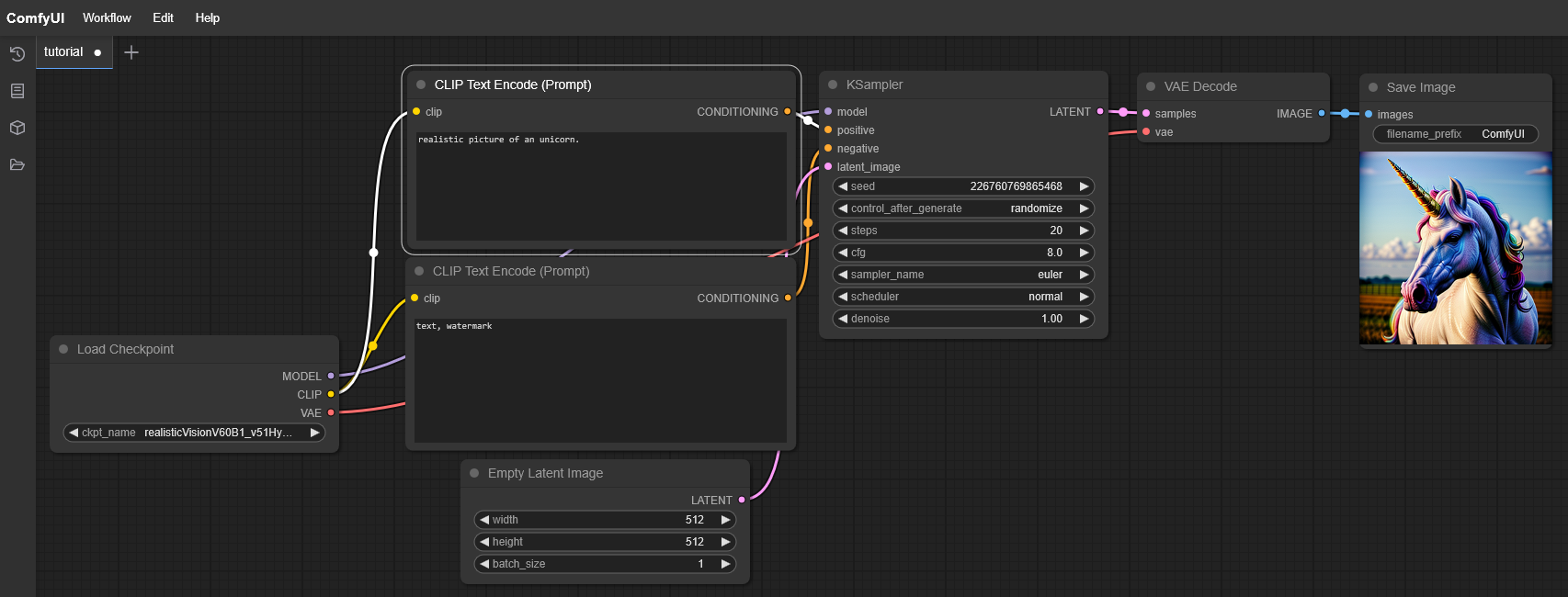

Bildmodelle

Um ComfyUI auch für Bildgenerierung zu nutzen, installieren wir die folgenden Modelle:

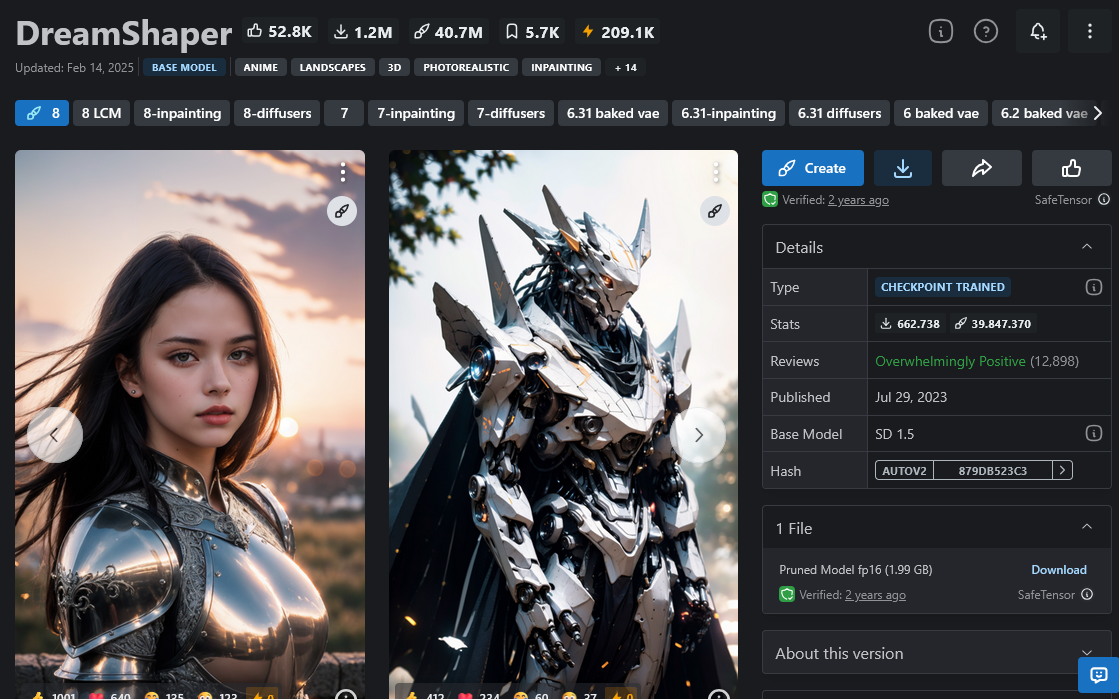

DreamShaper: Speziell für künstlerische Bilder.

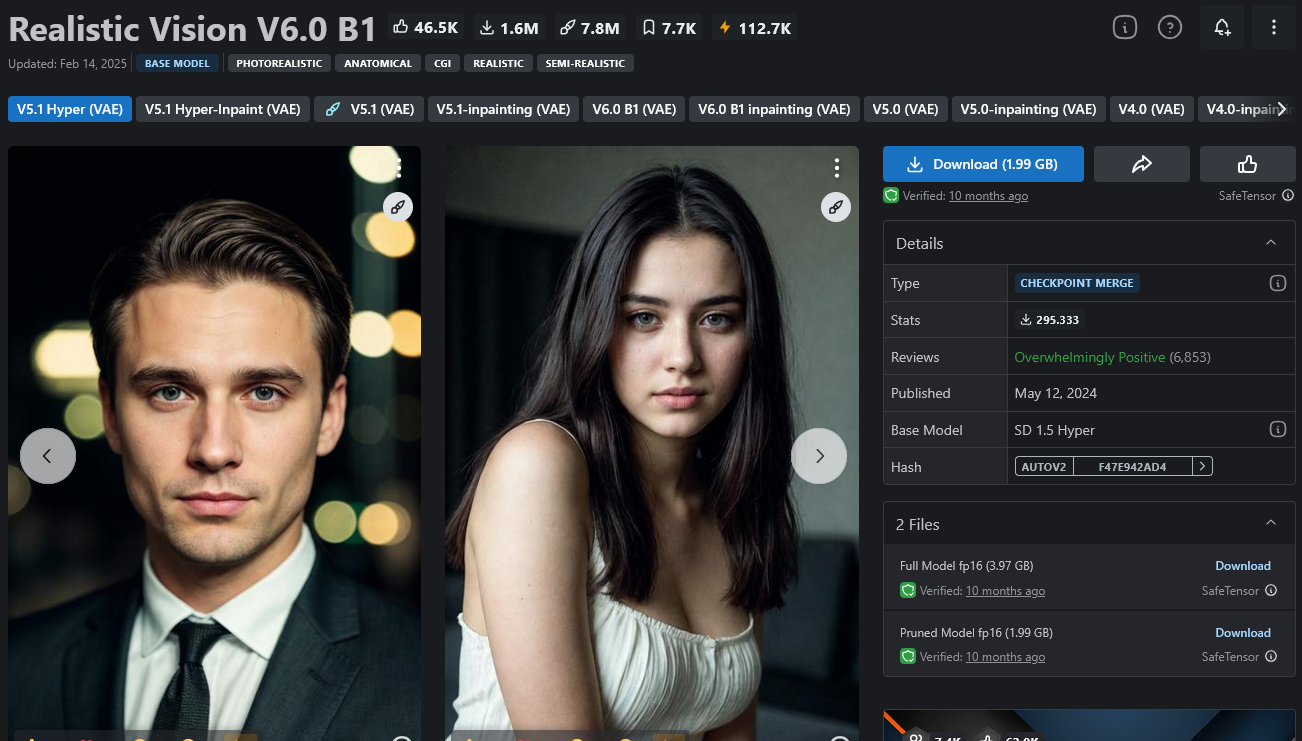

Realistic Vision V6.0 B1: Hochwertige realistische Bilder.

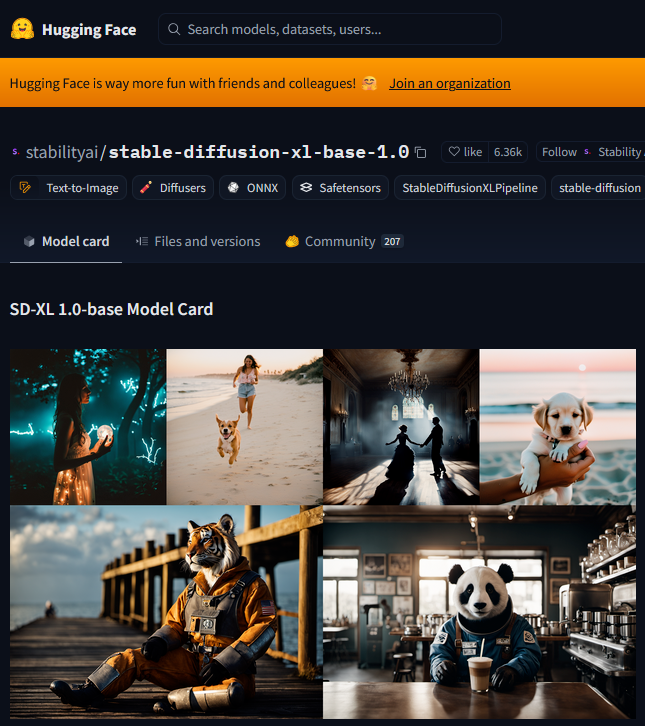

Stable Diffusion XL (SDXL): Allgemeines leistungsfähiges KI-Modell.

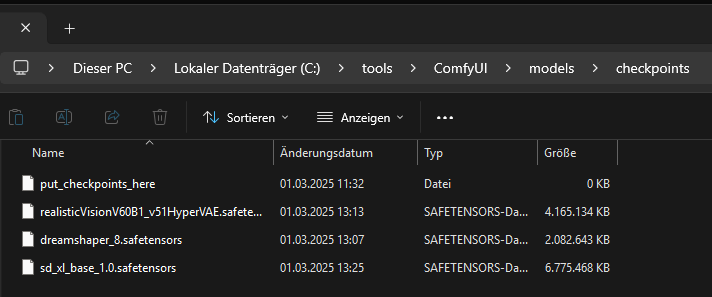

Diese Modelle müssen in C:\tools\ComfyUI\models\checkpoints gespeichert werden.

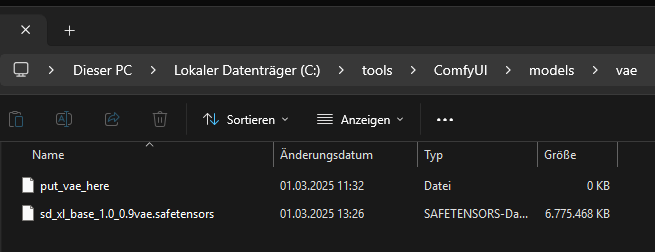

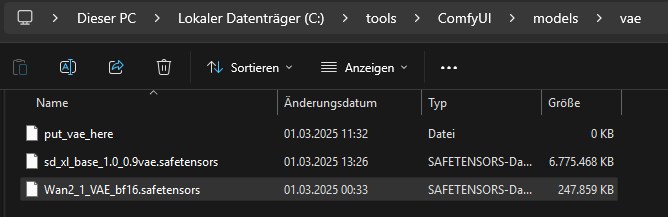

Die VAE-Datei für SDXL kommt nach C:\tools\ComfyUI\models\vae\.

DreamShaper Modell: https://civitai.com/models/4384/dreamshaper

Realistic Vision V6.0 B1 Modell: https://civitai.com/models/4201/realistic-vision-v60

Stable Diffusion XL (SDXL) Modell:

https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_base_1.0.safetensors

VAE:

https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_base_1.0_0.9vae.safetensors

Alle Modelle müssen in den Ordner C:\tools\ComfyUI\models\checkpoints verschoben werden.

Die VAE Datei von Stable Diffusion XL nach

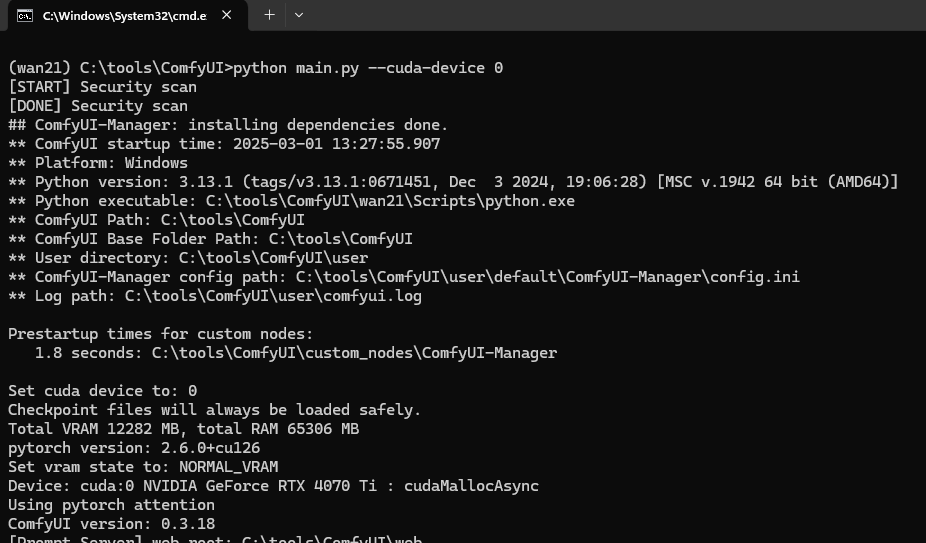

ComfyUI starten und ein erstes Bild generieren

python main.py –cuda-device 0

Video-Modelle für Wan 2.1

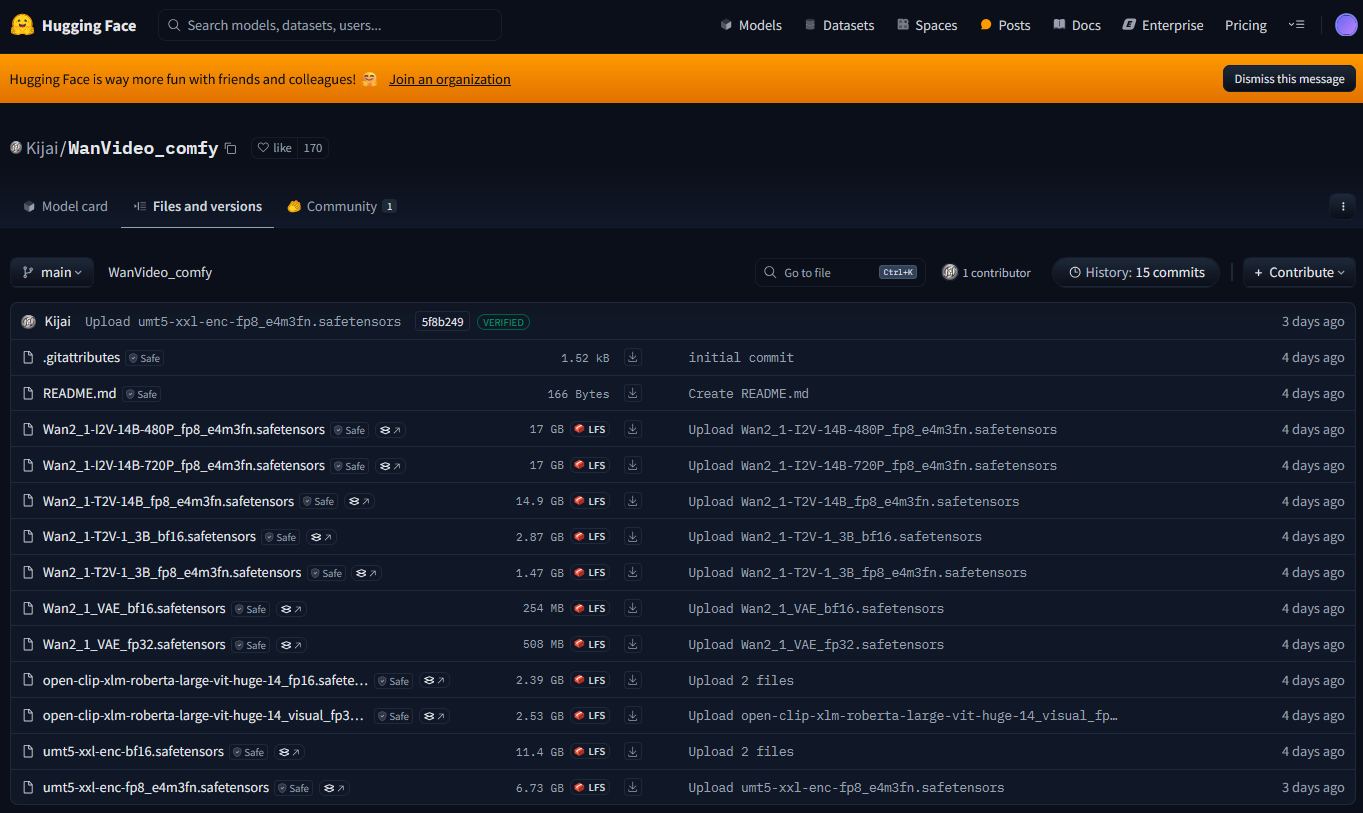

Da wir den ComfyUI-WanVideoWrapper nutzen, verwenden wir für die Erstellung von Videos ein Video-Model, welches für den Wrapper trainiert wurde: https://huggingface.co/Kijai/WanVideo_comfy/tree/main

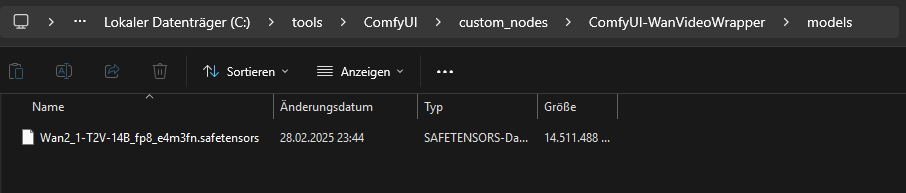

Innerhalb des Wrappers benötigen wir den Ordner “models”. Der Ordner fehlt nach der Installation.

Innerhalb des “models” Ordners kopieren wir anschließend das Text to Video (T2V) Model:

https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Wan2_1-T2V-14B_fp8_e4m3fn.safetensors

„T2V“ steht für Text-to-Video. 14B Parameter sind ein Kompromiss aus Qualität und Rechengeschwindigkeit. fp8 (8-Bit) benötigt weniger VRAM als fp16 oder fp32.

Die VAE Datei kopieren wir nach C:\tools\ComfyUI\models\vae\

https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Wan2_1_VAE_bf16.safetensors

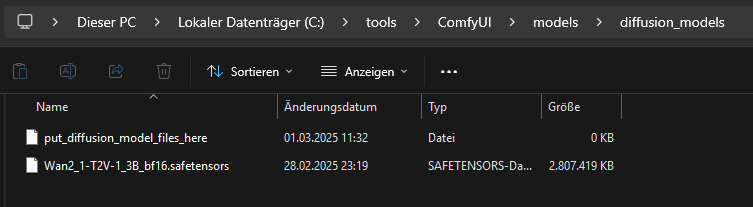

Das Diffusion-Model wird nach C:\tools\ComfyUI\models\diffusion_models\ kopiert

https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Wan2_1-T2V-1_3B_bf16.safetensors

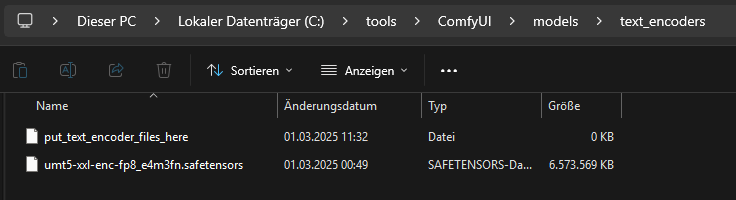

Als Text Encoder verwenden wir: https://huggingface.co/Kijai/WanVideo_comfy/blob/main/umt5-xxl-enc-fp8_e4m3fn.safetensors

Diese Datei kopieren wir nach “C:\tools\ComfyUI\models\text_encoders\”.

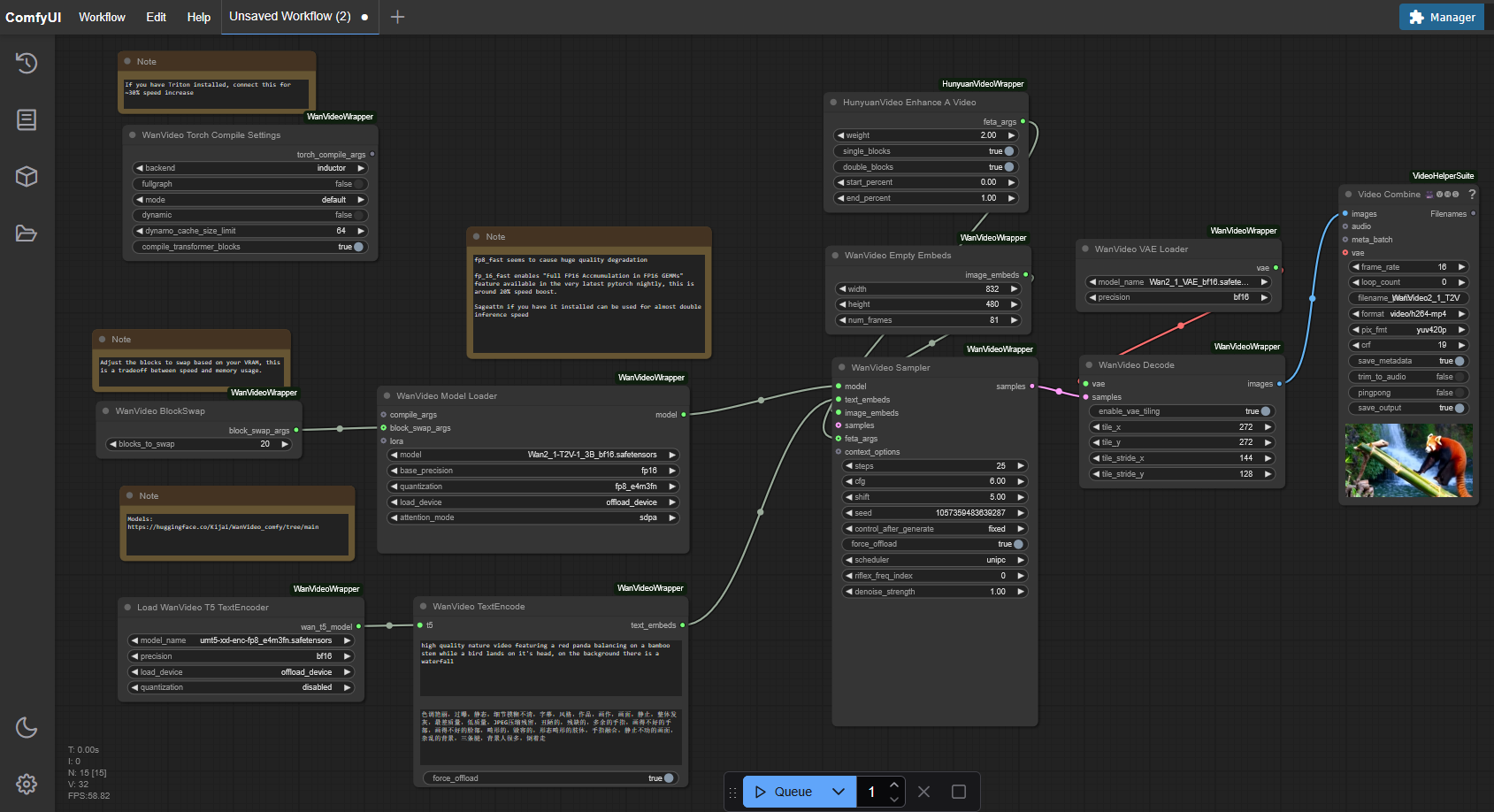

Workflow für Wan 2.1 einrichten

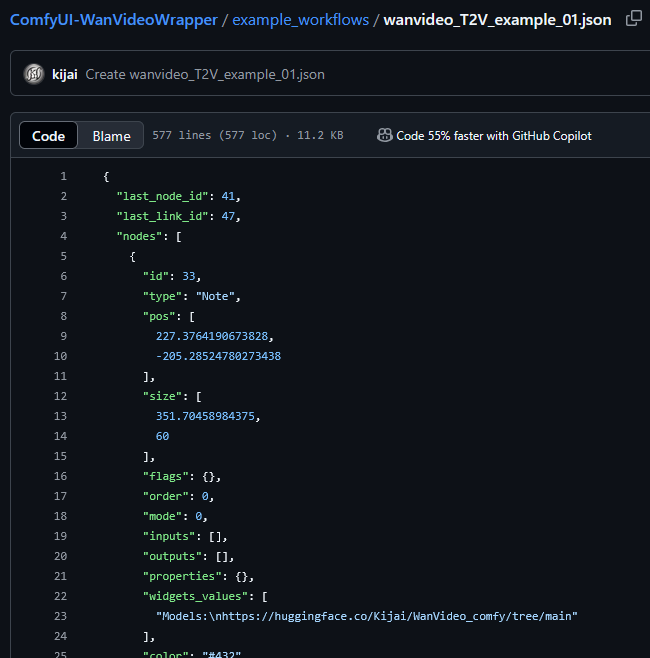

Um das neue Wan 2.1 Modell unter ComfyUI nutzen zu können, benötigen wir anschließend den passenden Workflow: https://github.com/kijai/ComfyUI-WanVideoWrapper/blob/main/example_workflows/wanvideo_T2V_example_01.json

Den JSON-Inhalt kopieren und in ComfyUI als neuen Workflow einfügen.

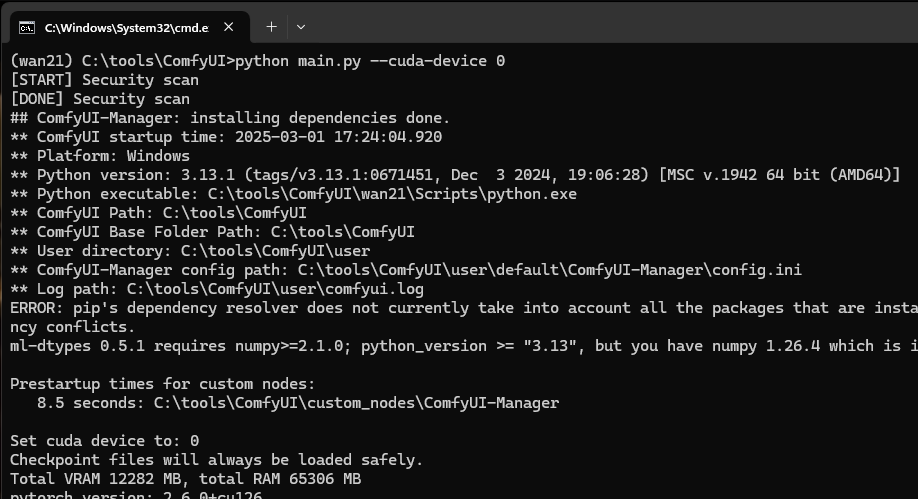

ComfyUI starten und testen

Anschließend kann ComfyUI gestartet werden:

python main.py –cuda-device 0