Ich habe einen weiteren Versuch gewagt, Musik mit KI zu generieren. Während die Technik in der Vergangenheit...

Die Automatisierung der Generierung von KI-Inhalten bietet eine effiziente Lösung, um den manuellen Aufwand bei der Erstellung...

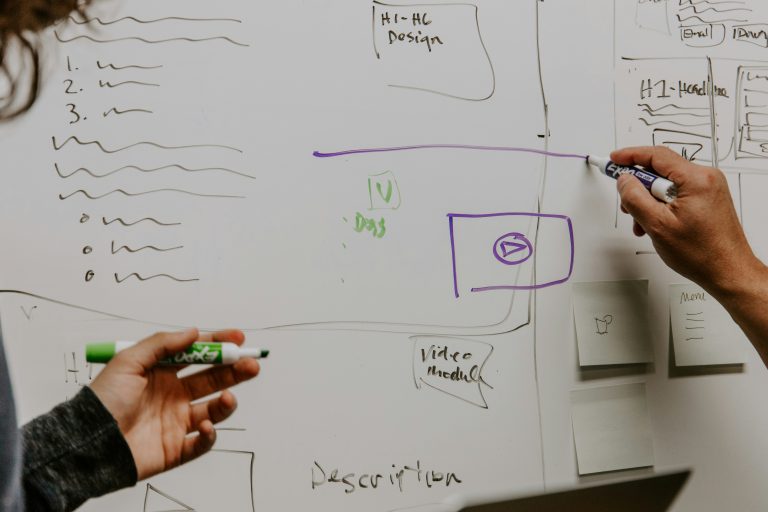

In der modernen Softwareentwicklung vollzieht sich ein Paradigmenwechsel da die Hürde komplexe und maßgeschneiderte Softwarelösungen zu erstellen...

Das Ziel war zu prüfen, ob es möglich ist, innerhalb weniger Stunden und unter Zuhilfenahme eines Large...

Einleitung In einem vorangegangenen Artikel wurde der Prozess des Transfer Learnings unter Verwendung des NVIDIA TAO Toolkits...

Einleitung In diesem Guide richten wir eine KI-Entwicklungsumgebung mit dem NVIDIA TAO Toolkit ein. Mein Ziel ist...

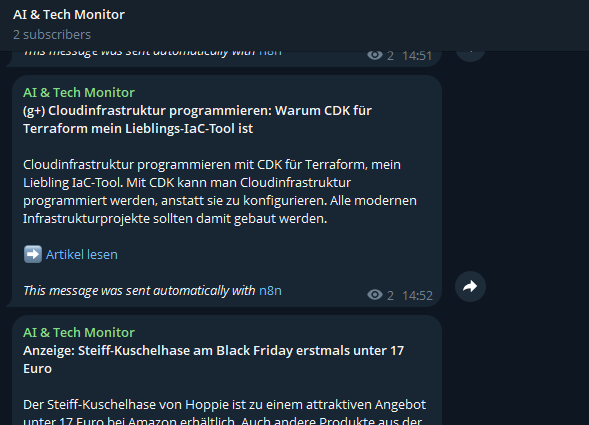

Einleitung Jeden Tag erscheinen hunderte neue Artikel über KI und Technik. Niemand hat die Zeit, das alles...

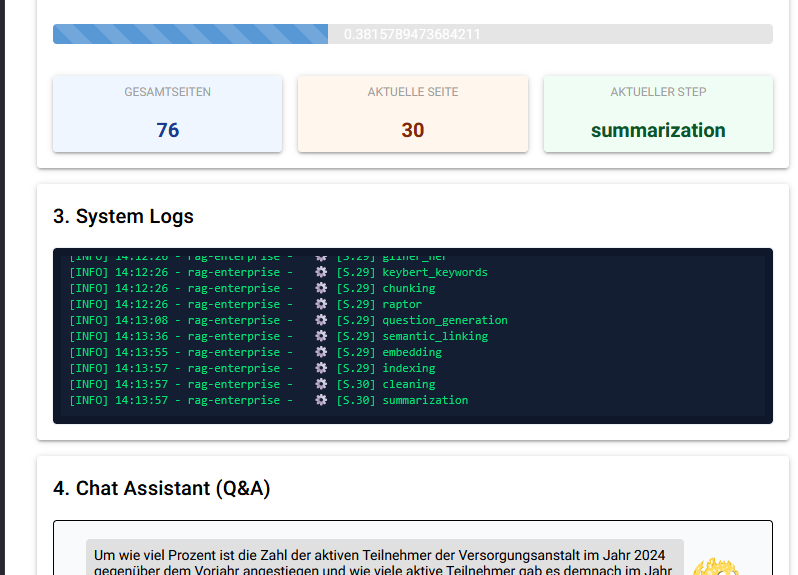

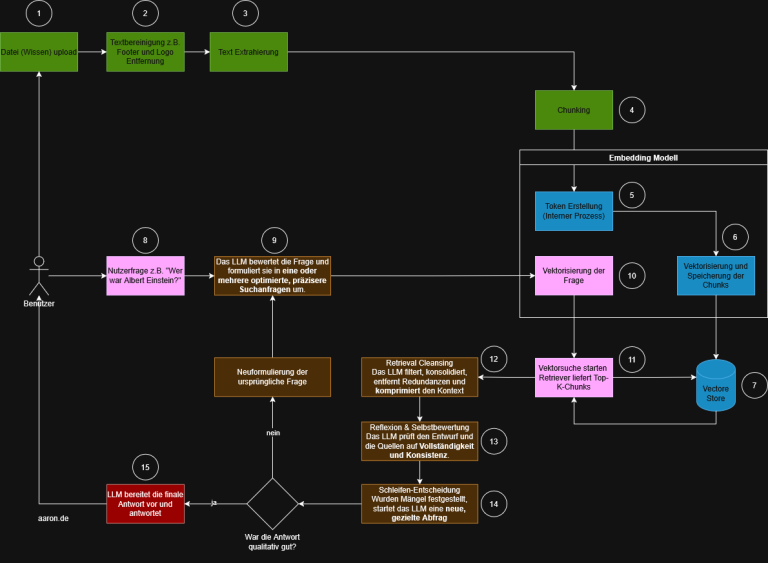

RAG Retrieval-Augmented Generation (RAG) ist heute eine verbreitete Methode, um Large Language Models mit externem Wissen zu...

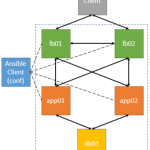

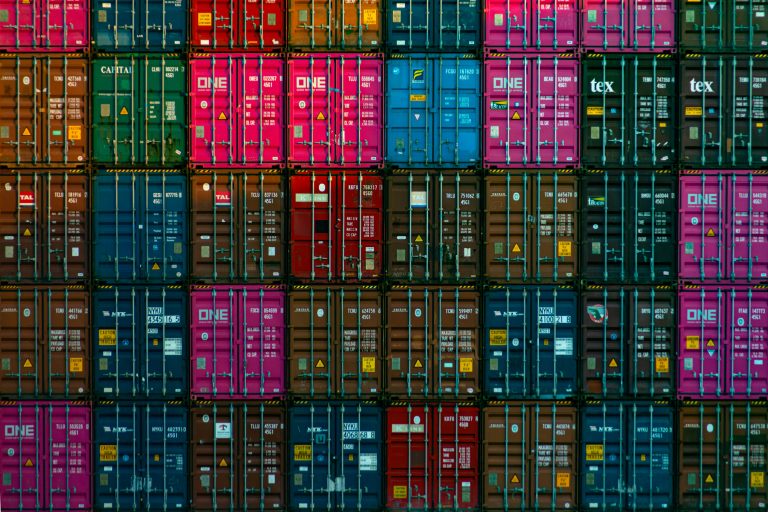

Dieser Leitfaden beschreibt, wie die Docker Engine auf Debian 12 (Bookworm) installiert und so konfiguriert wird, dass...

Normalerweise schreibe ich über Technik, aber heute geht es um ein Experiment an der Schnittstelle von Technologie...

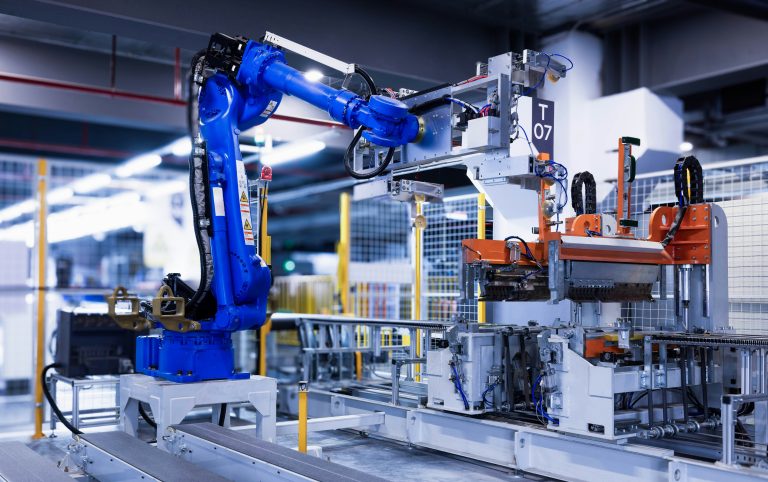

Der folgende Podcast wurde via KI generiert. Einleitung In der modernen industriellen Fertigung ist die vorausschauende Wartung,...

Telegram ist mehr als nur eine Messaging-App. Es hat sich zu einer vielseitigen Plattform für die Automatisierung...

Dieser Leitfaden behandelt die Funktion, die Komponenten und die praktische Implementierung einer Web Application Firewall (WAF). Definition...

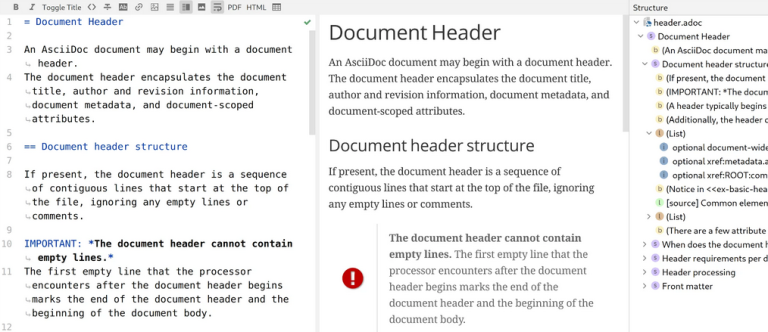

Softwaredokumentation ist heute mehr als eine Pflichtaufgabe. Sie ist Teil des Entwicklungsprozesses und muss genauso agil, versionierbar...

Einleitung: Weshalb die Herrschaft über Daten den Erfolg von KI bestimmt Künstliche Intelligenz entsteht nicht im luftleeren...

In Machine Learning gibt es viele Paradigmen und Verfahren von Supervised und Unsupervised Learning über Semi und...

In Teil 1 haben wir gesehen, wie entscheidend eine saubere Dokumentenaufbereitung und ein durchdachtes Chunking für die...

Retrieval Augmented Generation, kurz RAG, verbindet die Leistungsfähigkeit von Sprachmodellen mit dem spezifischen Wissen eines Unternehmens. Der...

Einleitung Große Sprachmodelle (Large Language Models, LLMs) wie Llama 3.x werden in einem aufwendigen Vortrainingsprozess auf gewaltigen...

Einleitung Spätestens mit dem Aufkommen großer Sprachmodelle (LLMs) wie GPT stellt sich vielen die Frage, wie man...

Einleitung Unstructured.io ist ein Open-Source-Framework zur strukturierten Aufbereitung unstrukturierter Dokumente wie PDFs, Word-Dateien, HTML-Seiten oder E-Mails. Ziel...

Einleitung Retrieval Augmented Generation (RAG) ist ein Verfahren der natürlichen Sprachverarbeitung (NLP), bei dem ein Sprachmodell mit...

Einleitung Stanza ist eine Open Source NLP Bibliothek der Stanford University, die auf modernen neuronalen Netzen basiert....

In klassischen Softwareanwendungen sind Abläufe fest vorgegeben. Funktionen werden in bestimmter Reihenfolge aufgerufen, Übergaben sind klar definiert,...

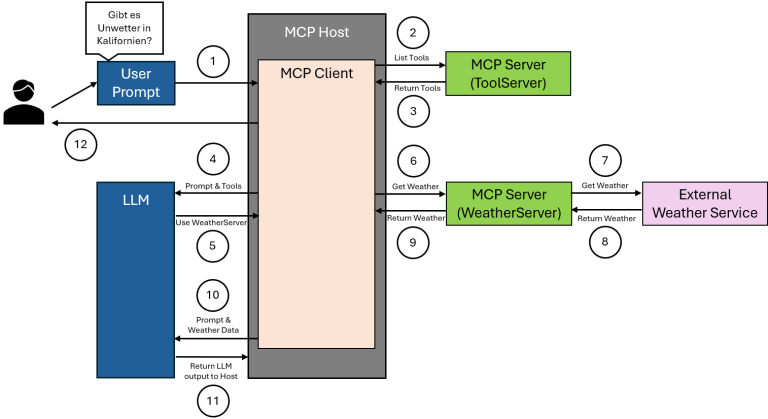

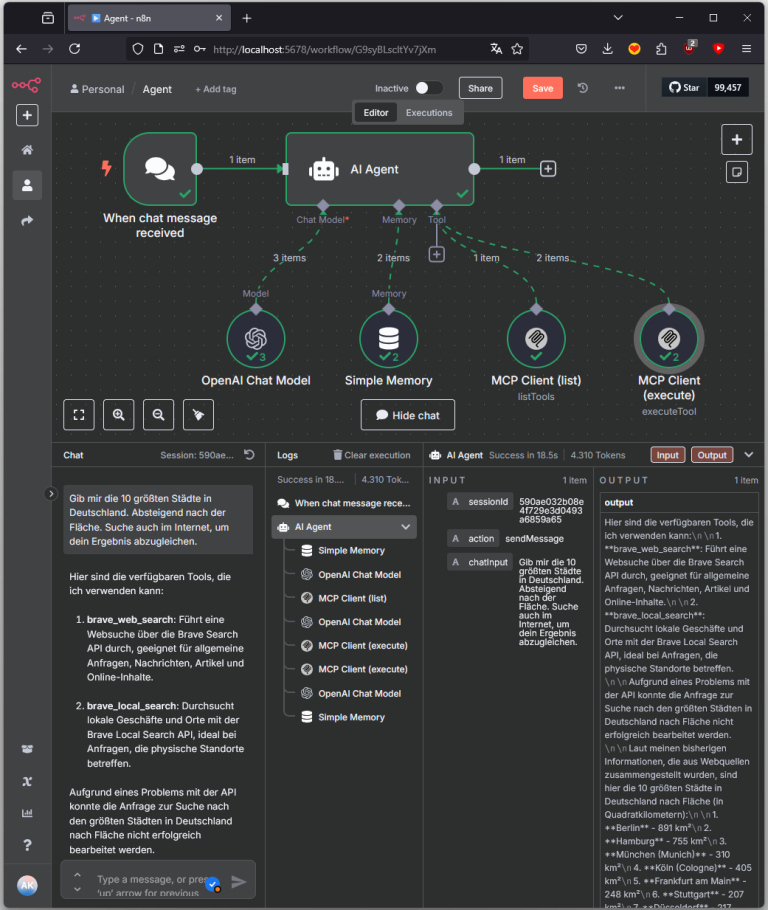

Dieser Beitrag beschreibt den Aufbau eines KI-gesteuerten Agentensystems in n8n, das über das Model Context Protocol (MCP)...

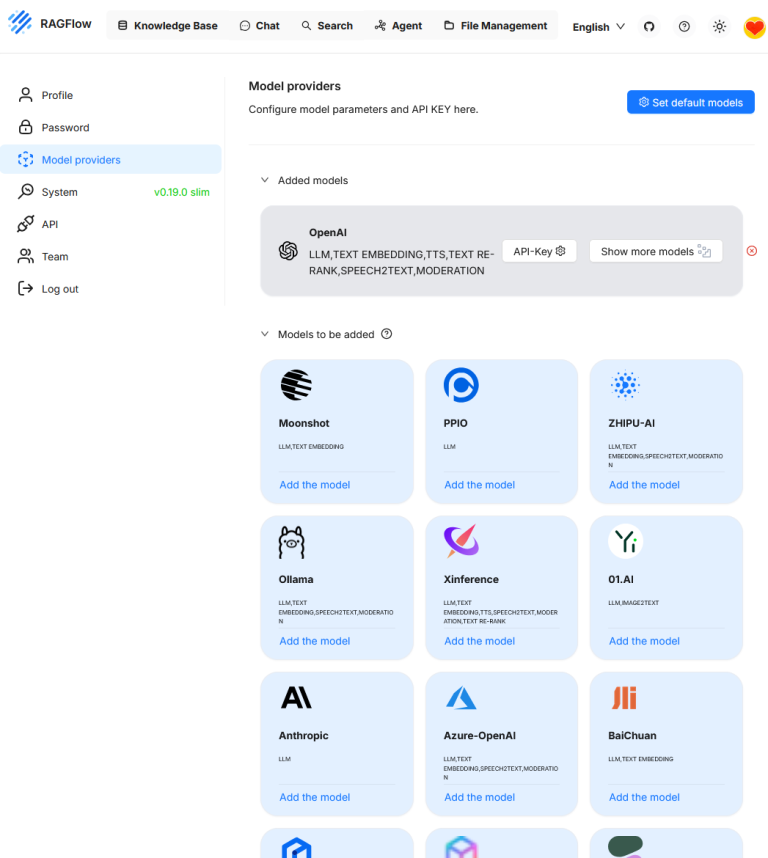

RAGFlow ist ein Framework zur strukturierten Umsetzung von Retrieval Augmented Generation (RAG)-Anwendungen. Es bietet eine modulare Architektur,...

Diese Anleitung basiert auf der Hugging Face CLI ab Version 0.34.4. In dieser Version wird die alte...

Die künstliche Intelligenz hat die Fähigkeit erlangt, aus reinen Textbeschreibungen detailreiche und komplexe Bilder zu erschaffen. Die...

Im Rahmen dieses Tests wird das Open-Source-Framework unstructured eingesetzt, um den Extraktionsprozess von Text aus strukturierten Dokumenten...

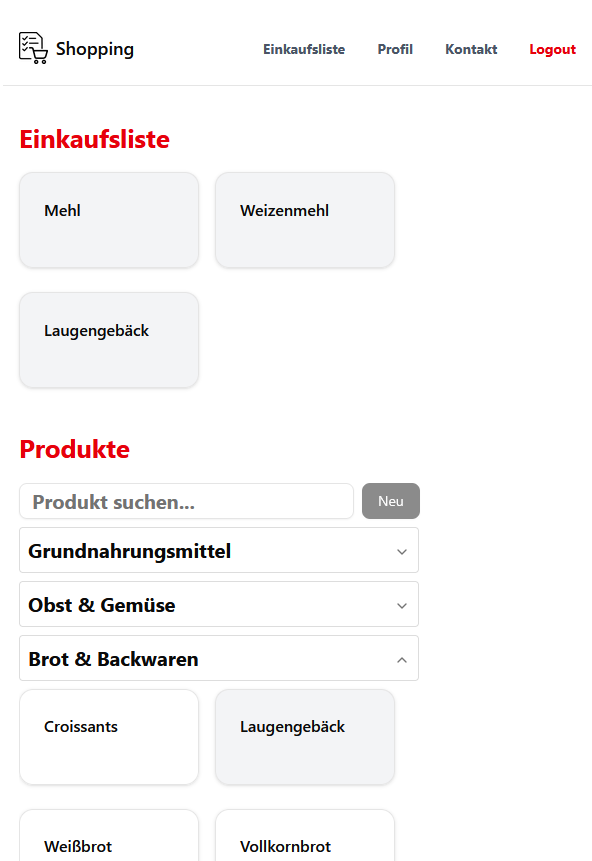

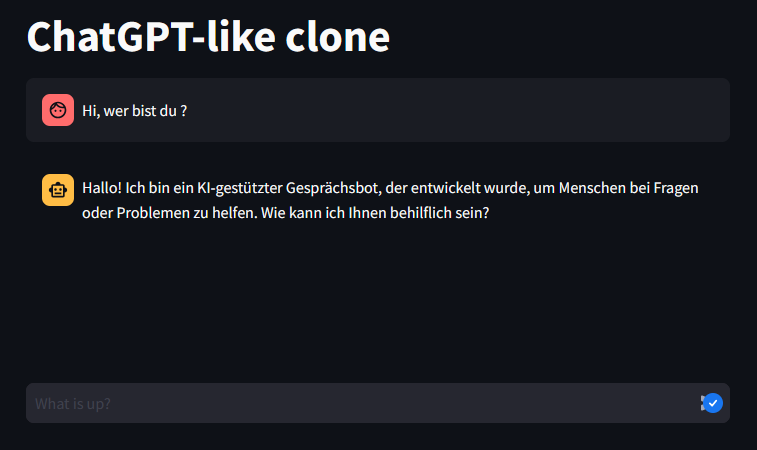

Ich habe dieses Projekt gestartet, um React praxisnah zu lernen – und nicht nur Tutorials zu verfolgen....

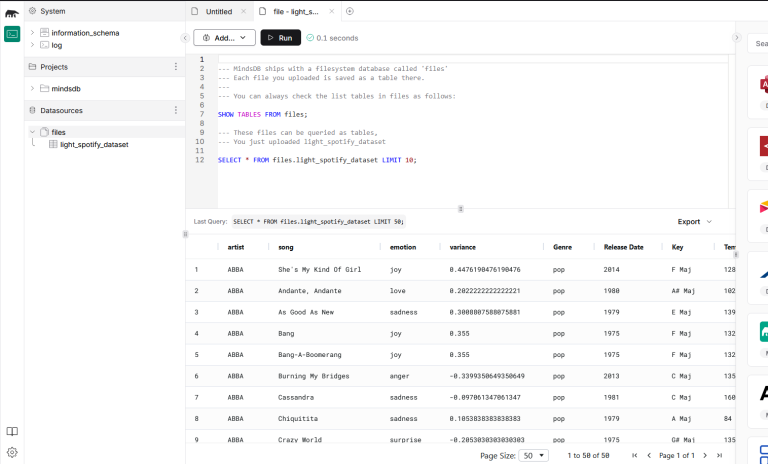

MindsDB ist eine Open-Source-Plattform, die entwickelt wurde, um maschinelles Lernen, Zeitreihenanalysen und die Integration großer Sprachmodelle direkt...

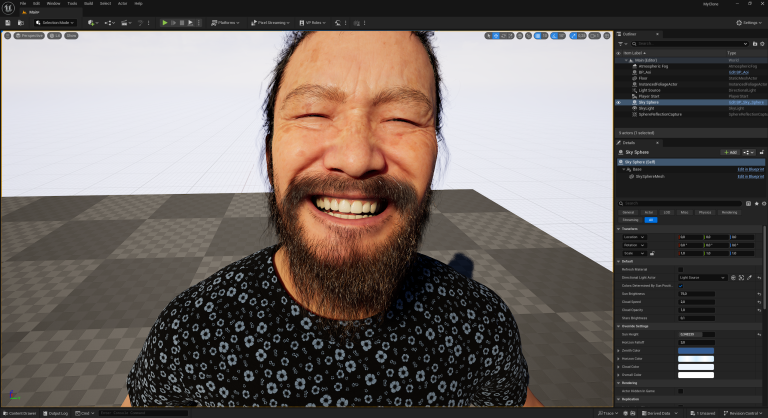

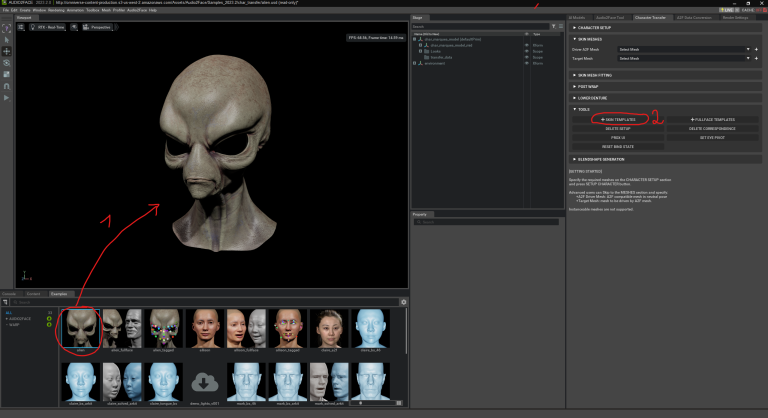

Die Übertragung von Gesichtsausdrücken in Echtzeit auf digitale Charaktere ist ein wichtiger Bestandteil moderner Animations- und Visualisierungsprozesse....

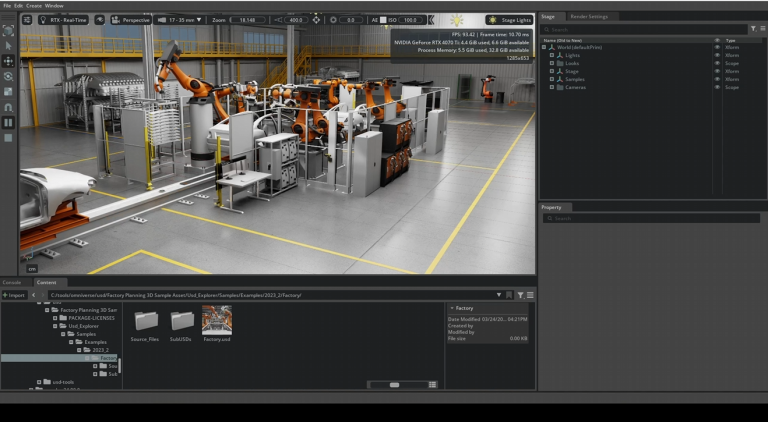

Audio2Face ist ein KI-gestütztes Tool innerhalb von NVIDIA Omniverse, das speziell dafür entwickelt wurde, realistische Gesichtsanimationen allein...

In diesem Projekt habe ich einen KI-Agenten entwickelt, der automatisch Veranstaltungen aus dem Raum NRW analysiert und...

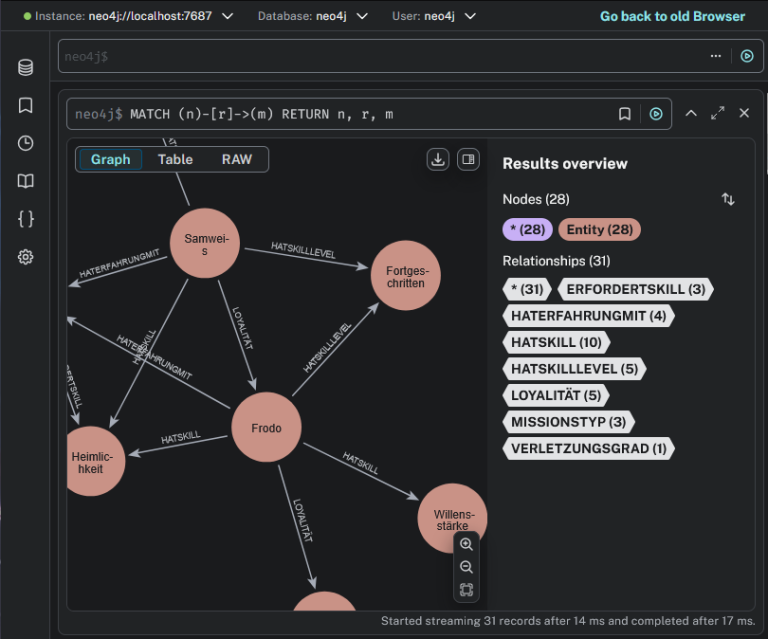

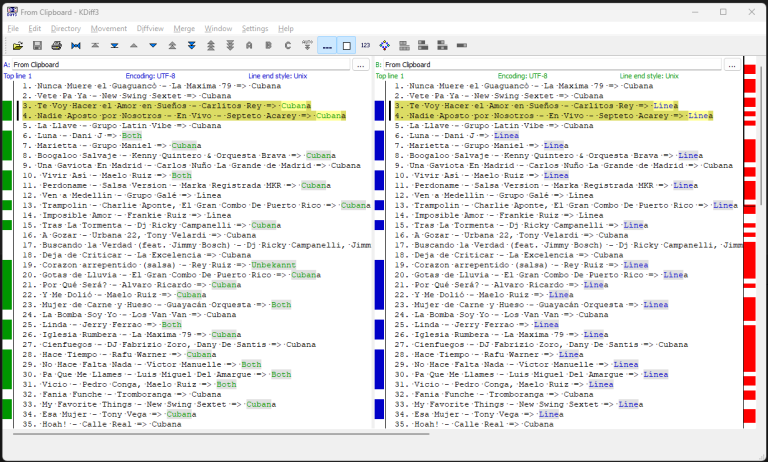

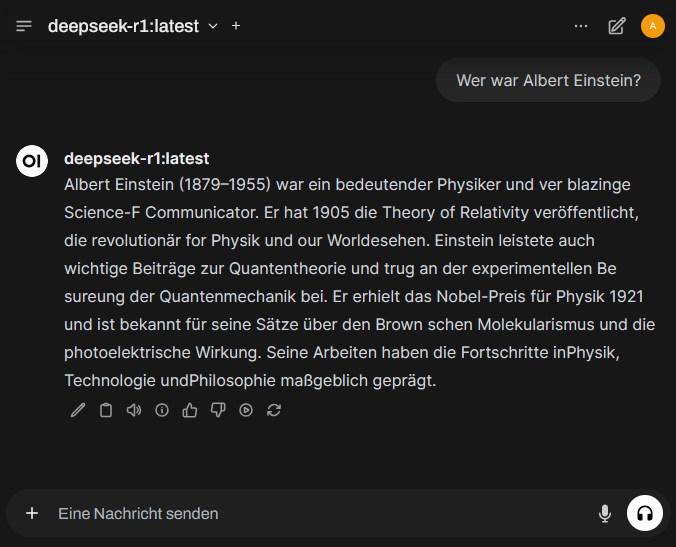

Die Fragestellung war, ob aktuelle Large Language Models (LLMs) wie GPT-4 oder DeepSeek in der Lage sind,...

Was ist Omniverse? Omniverse ist eine Plattform von NVIDIA, mit der man virtuelle 3D-Welten erstellen, verbinden und...

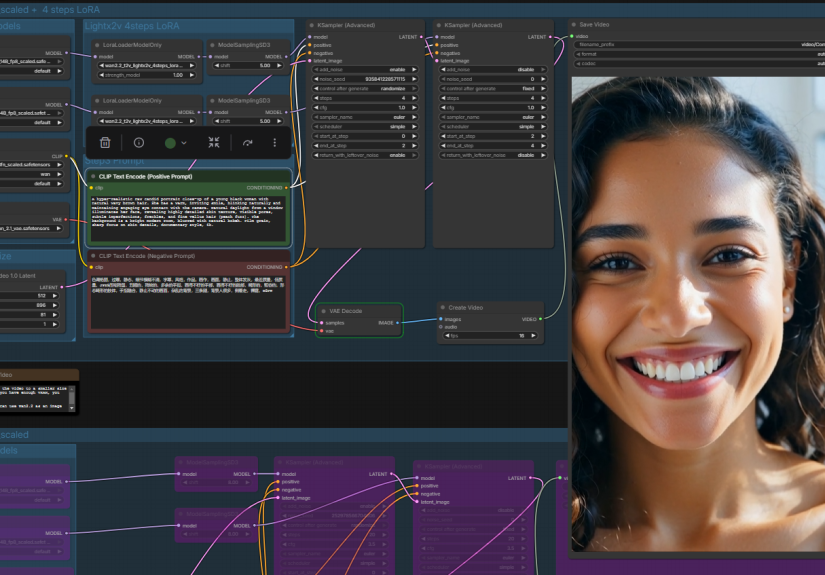

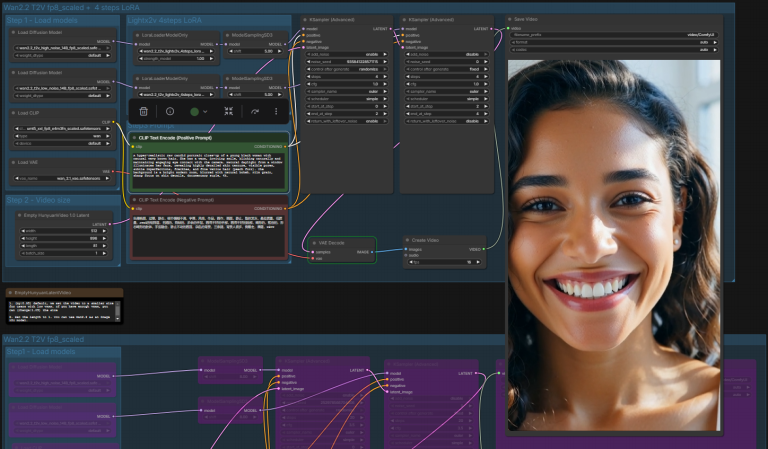

ComfyUI ist eine node-basierte Benutzeroberfläche zur Steuerung und Modifikation von KI-Modellen zur Bild- und Videoerstellung. Wan 2.1...

KI-Modelle liefern oft unstrukturierte oder unpräzise Antworten. Wer bessere Ergebnisse möchte, muss seine Prompts entsprechend anpassen. Eine...

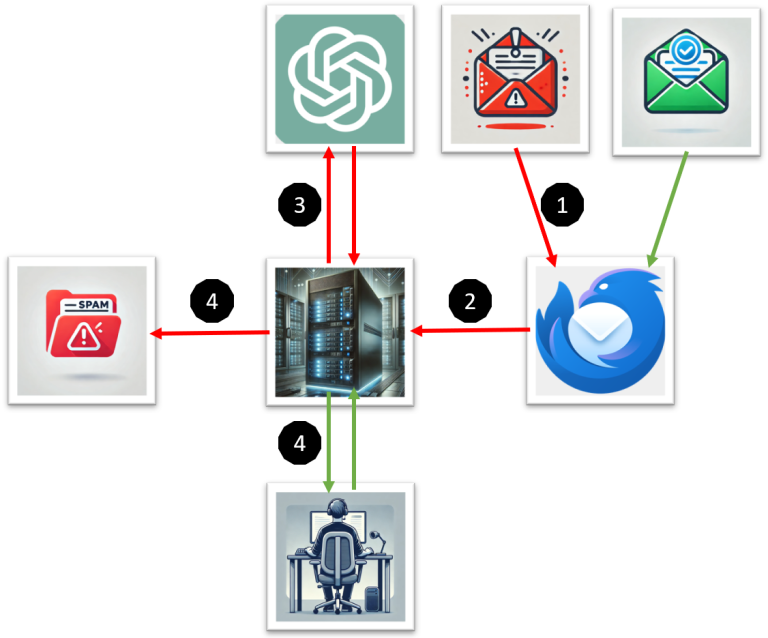

In diesem Projekt habe ich eine Thunderbird-Erweiterung entwickelt, die ChatGPT zur erweiterten Spam-Erkennung nutzt. Eingehende E-Mails werden...

Hier wurde Ollama mit NVIDIA-GPU-Unterstützung unter Docker auf einem Windows-11-System ausgeführt. Dabei kam OpenWebUI als benutzerfreundliche Oberfläche...

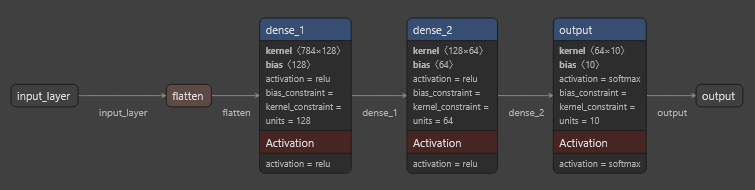

Dieser Code zeigt, wie ein künstliches neuronales Netzwerk mit dem MNIST-Datensatz trainiert wird, um handgeschriebene Ziffern (0-9)...

3. Liste der installierten Modelle anzeigen lassen. Die Liste sollte leer sein. 4. llama3.2 LLM und DeepSeekv3...

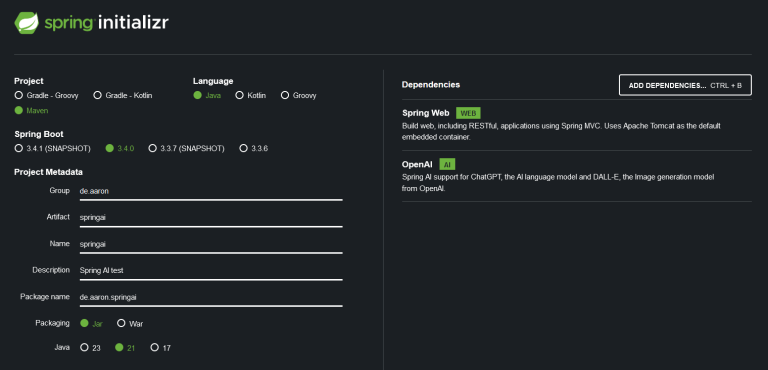

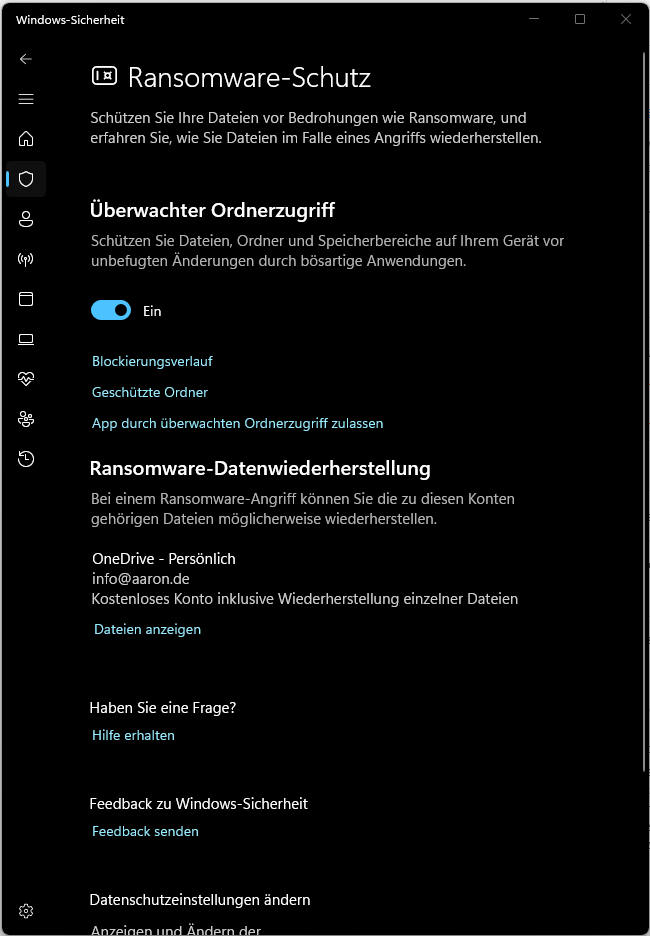

Frage via Spring AI an OpenAI senden und die Antwort anzeigen OpenAI Key erstellenhttps://platform.openai.com/settings/organization/api-keys Anschließend den Key...

In diesem Beitrag erkläre ich dir, wie du Whisper, ein KI-basiertes Tool von OpenAI, zur automatischen Transkription...

Erweiterte Firefox Einstellungen aufrufen: about:config network.trr.mode von 0 auf 2 umstellen.network.trr.uri auf https://mozilla.cloudflare-dns.com/dns-query umstellen. network.trr.mode ist eine...

Dieser Blogbeitrag behandelt das Konzept von Embeddings und Vektordatenbanken. Dabei wird zunächst erklärt, was Embeddings sind und...

Anfragen 1:1 via Streamlit an ChatGPT weiterleiten und die Antwort anzeigen. streamlit run ChatUI.py

Sende Nachricht via LangChain an ChatGPT Hier senden wir eine Nachricht via LangChain an ChatGPT und geben...

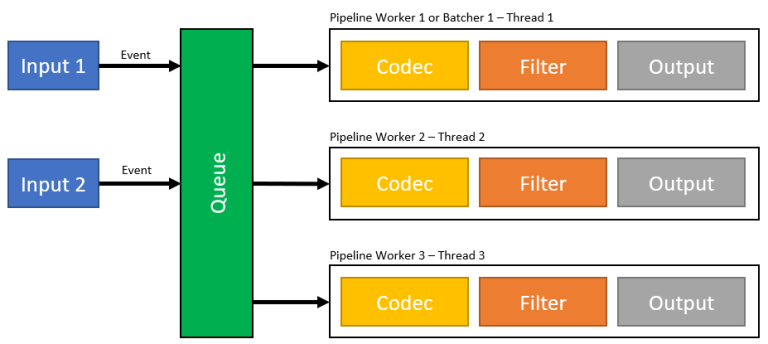

Logstash Logstash is an Event Processing Framework. With Logstach you can import data from different kind of...

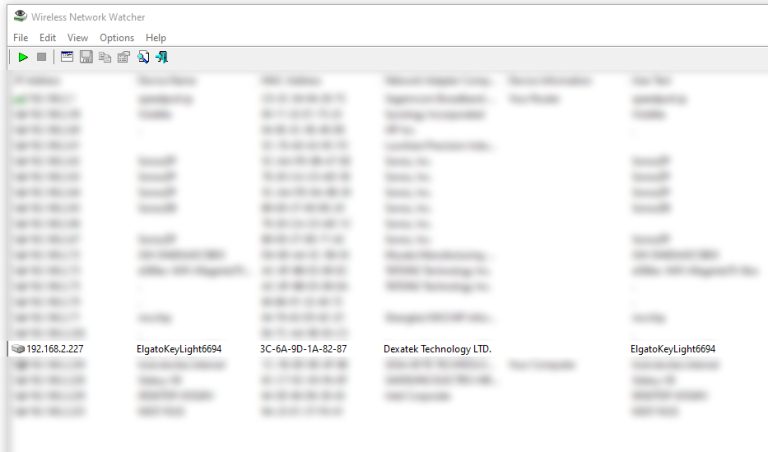

Search for the IP address of your Key Light via Wireless Network Watcher e.g. 192.168.2.227 Your Key...